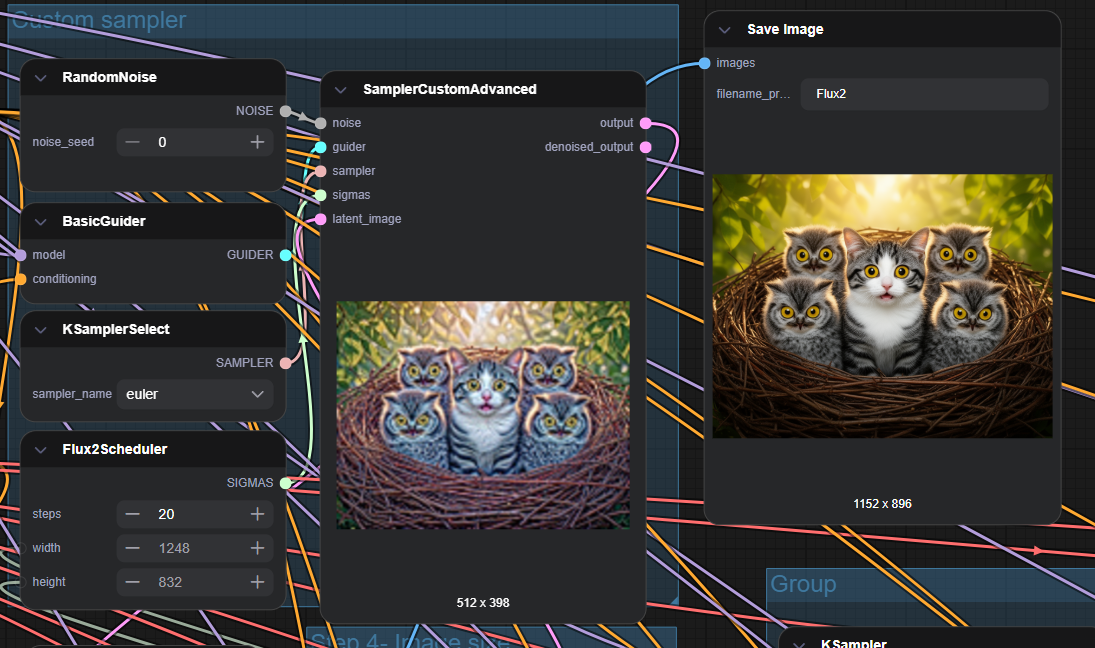

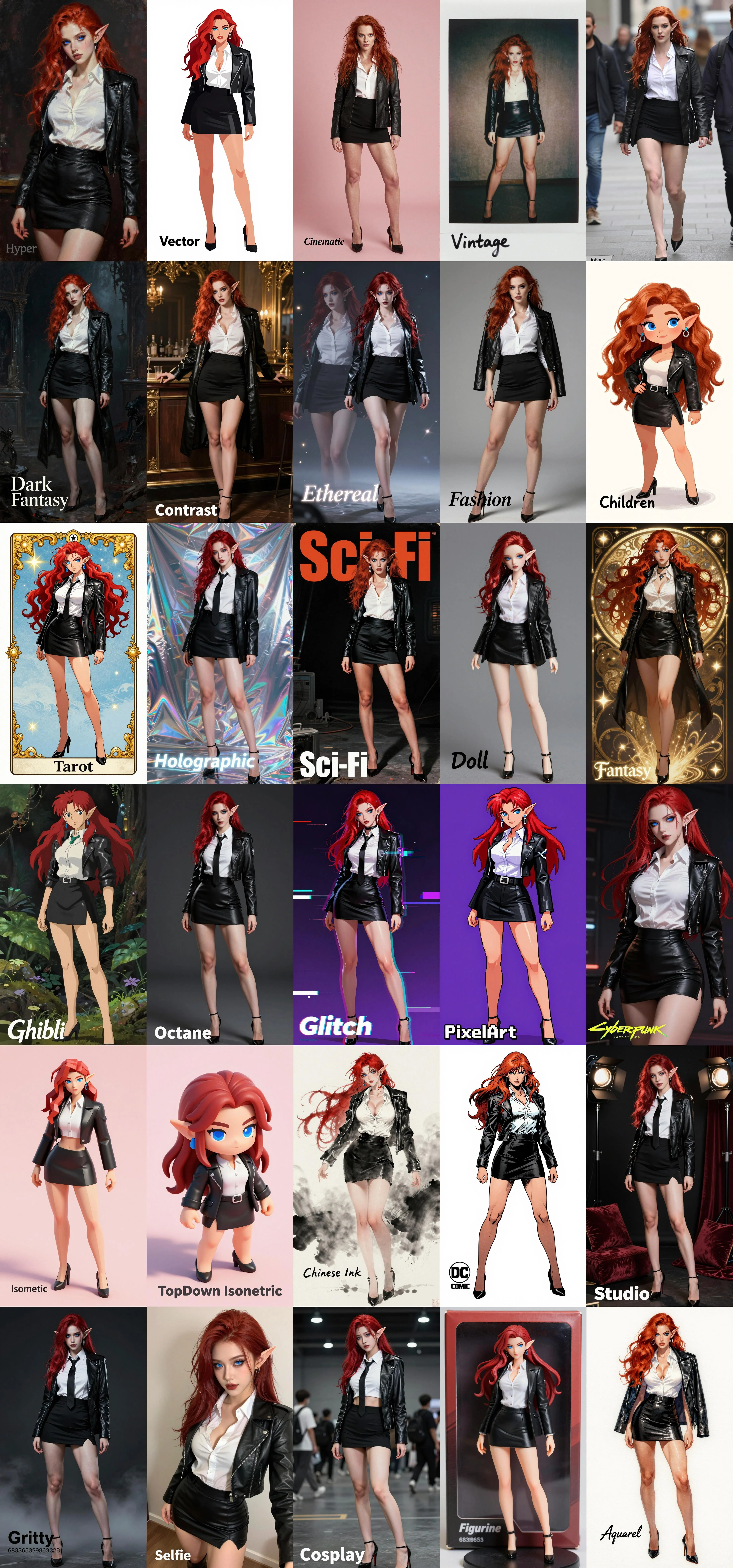

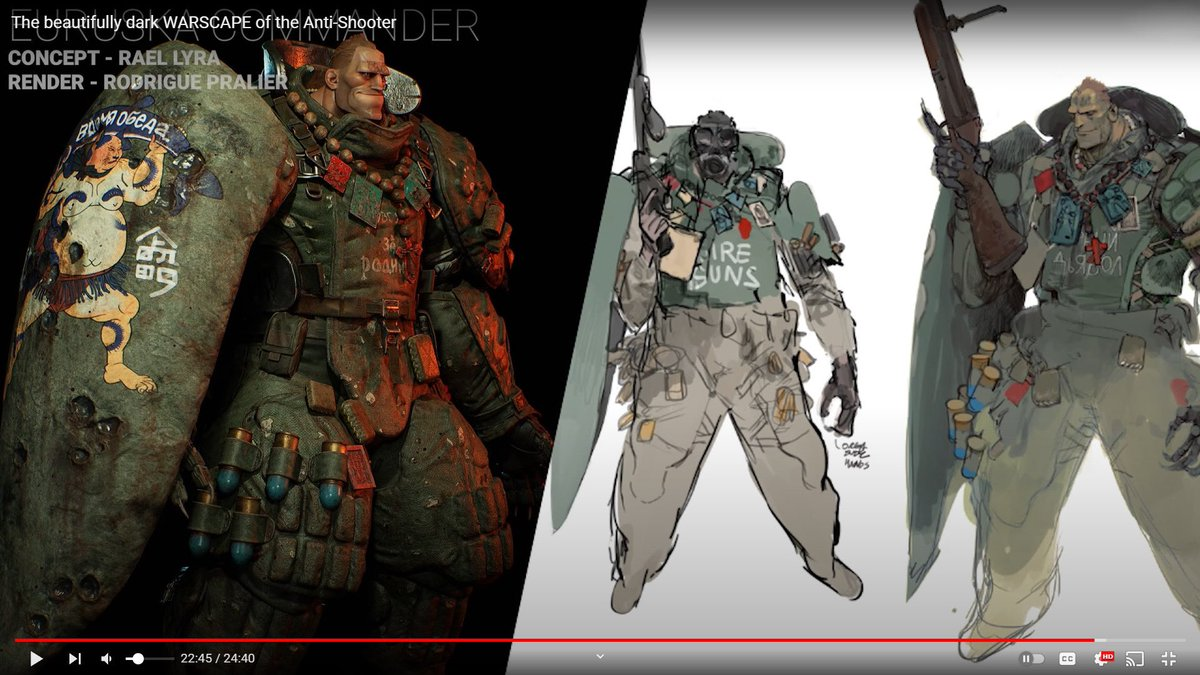

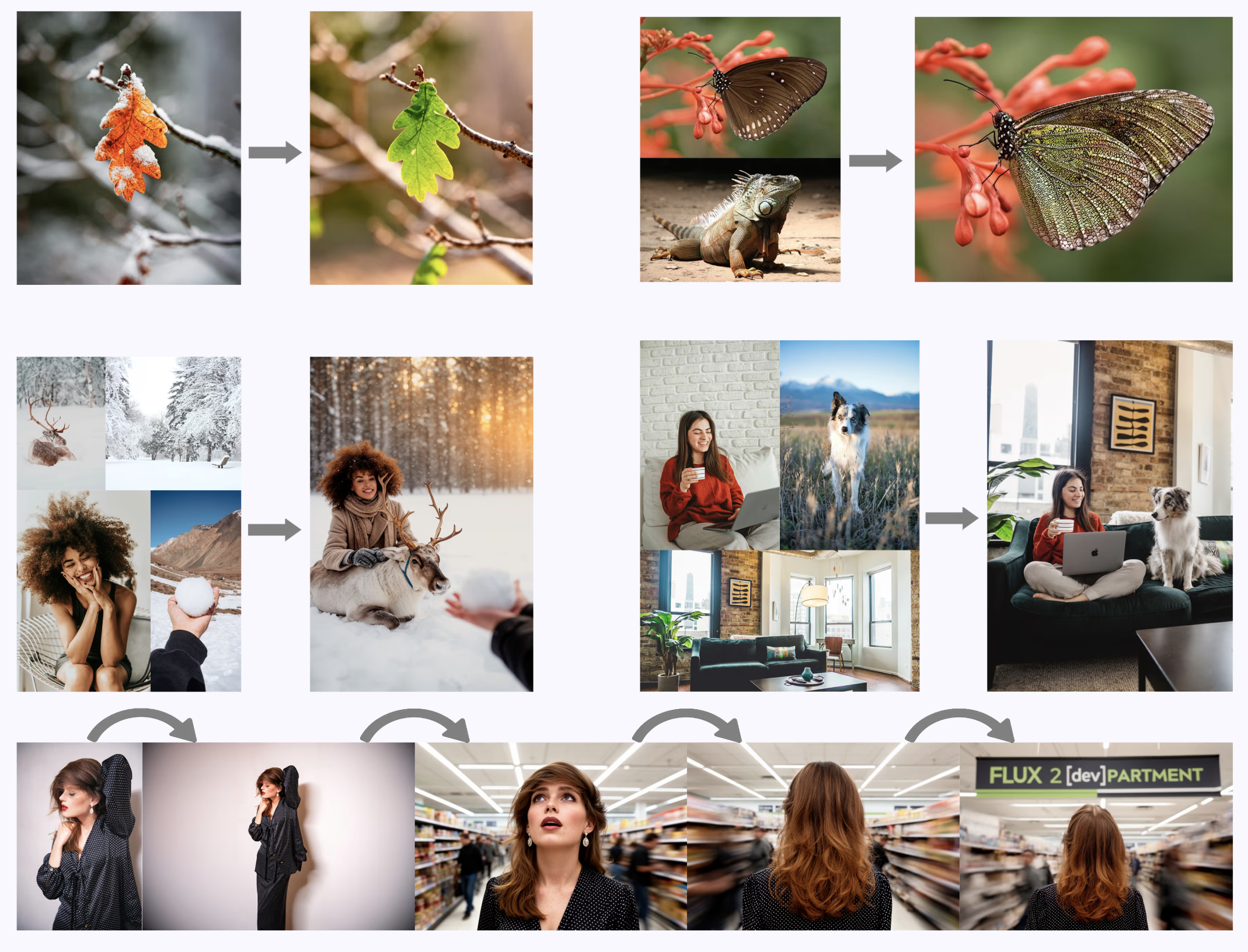

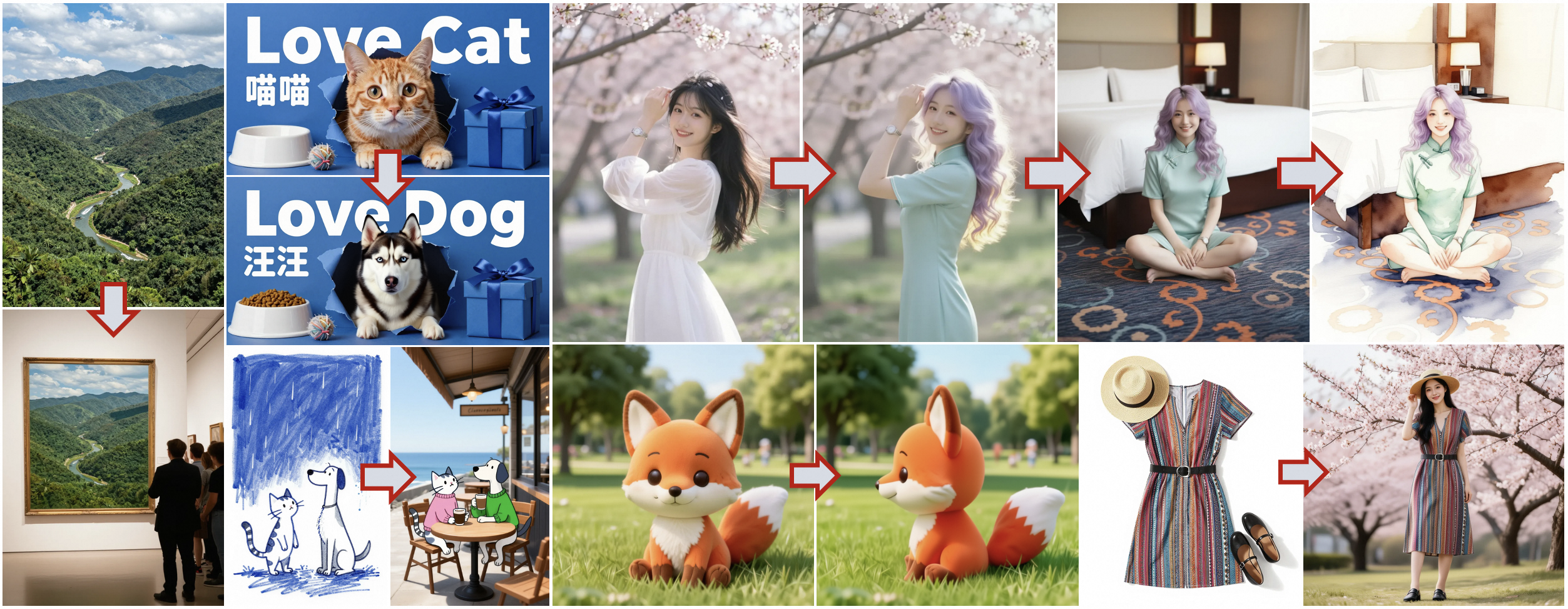

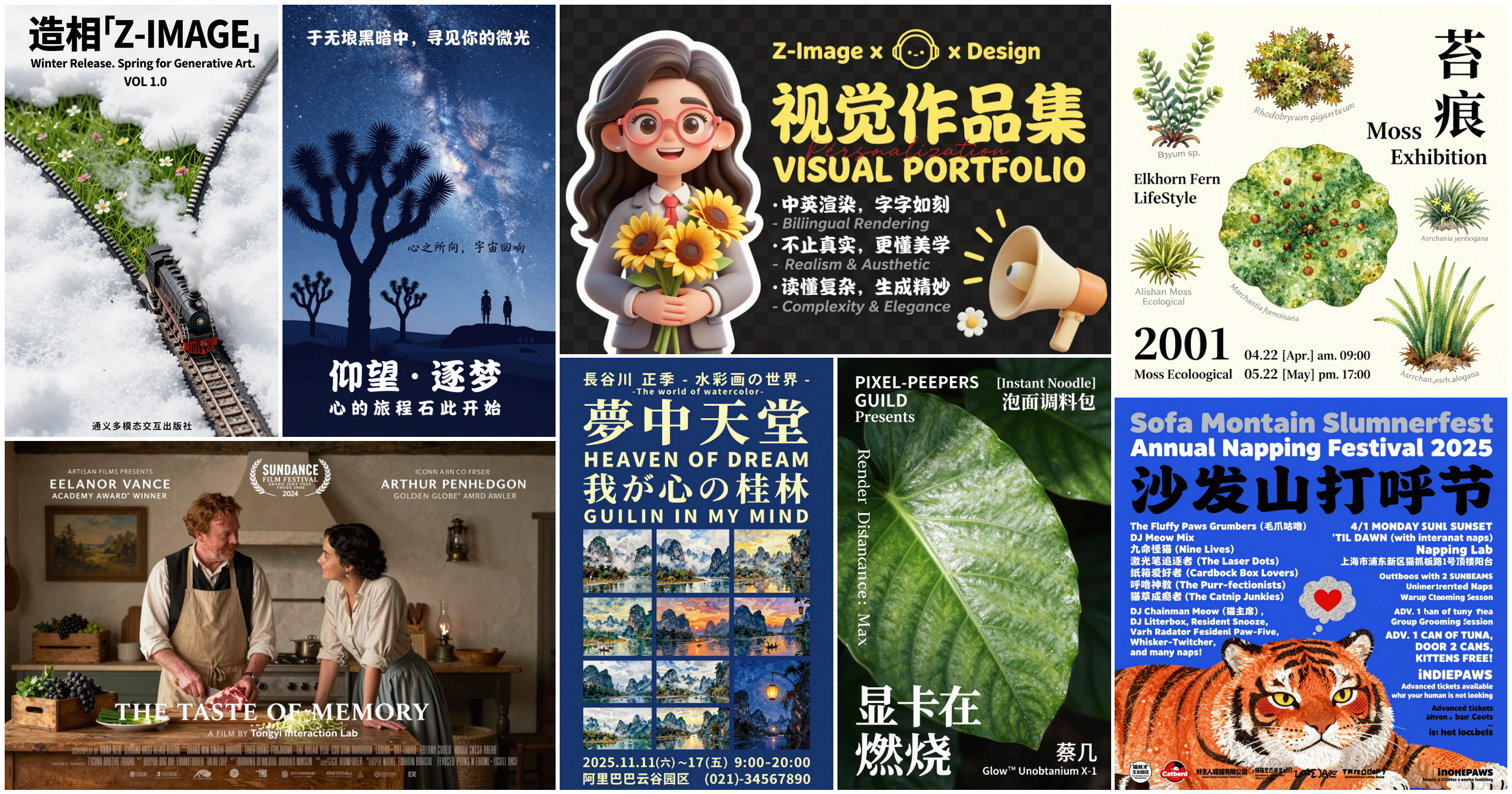

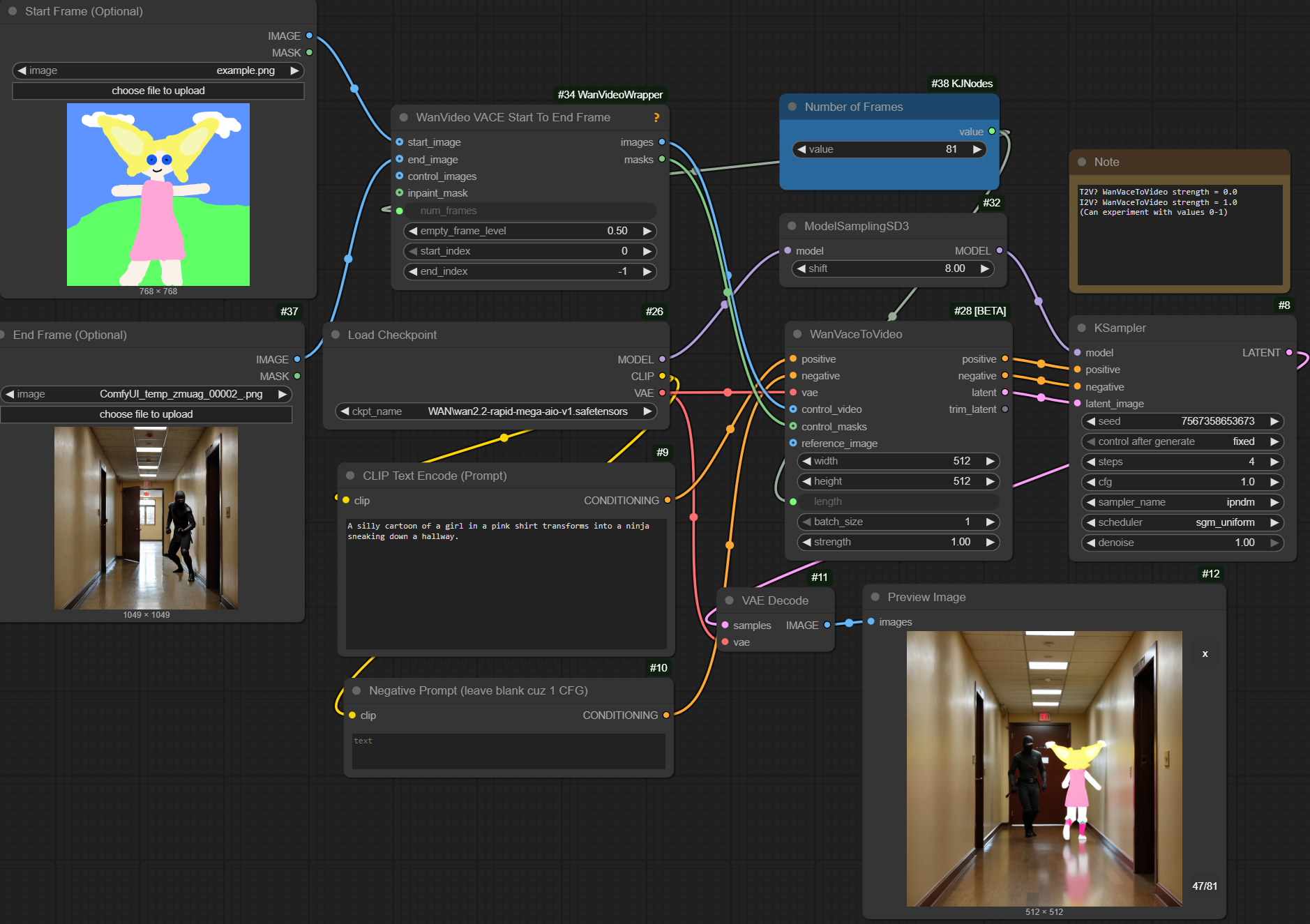

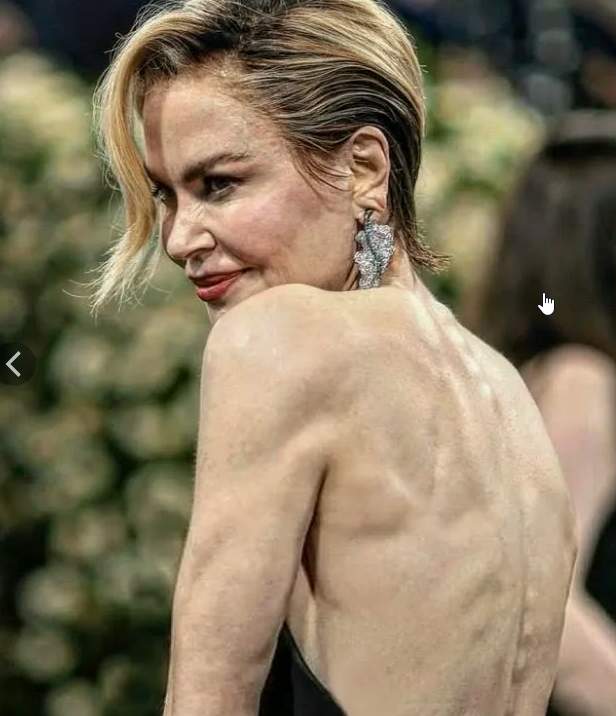

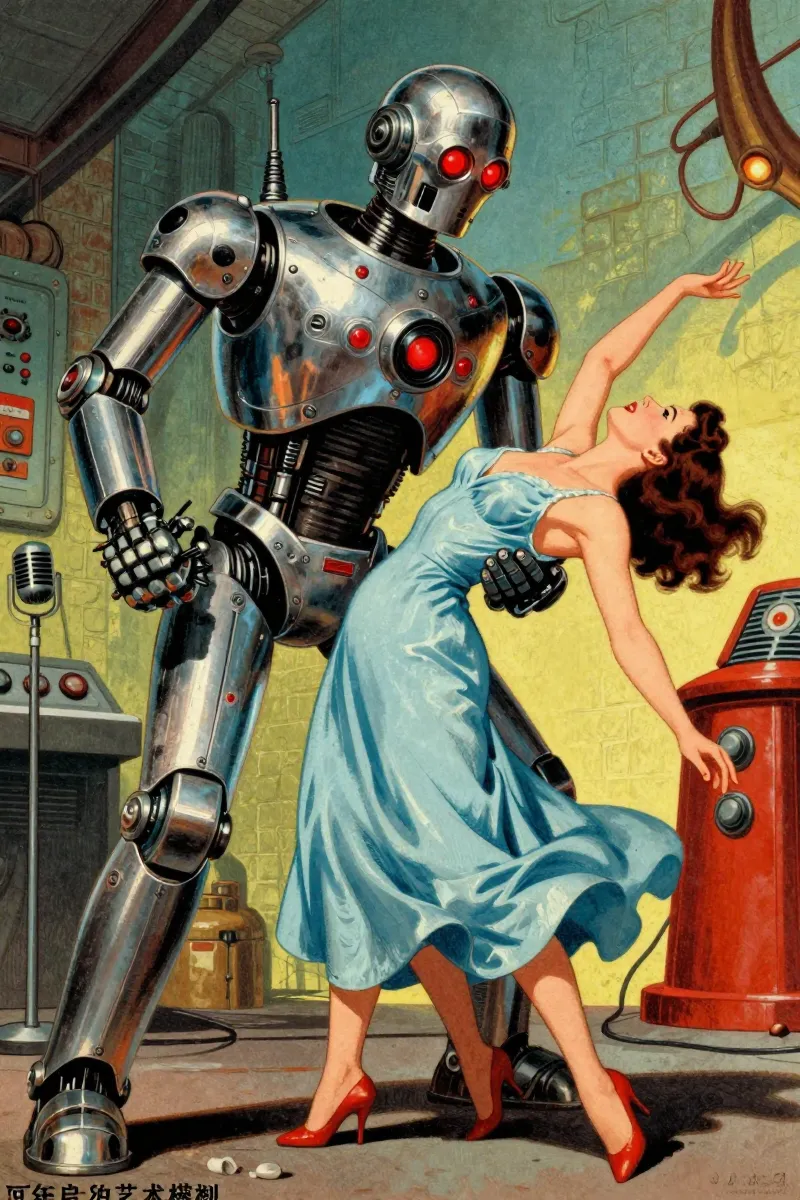

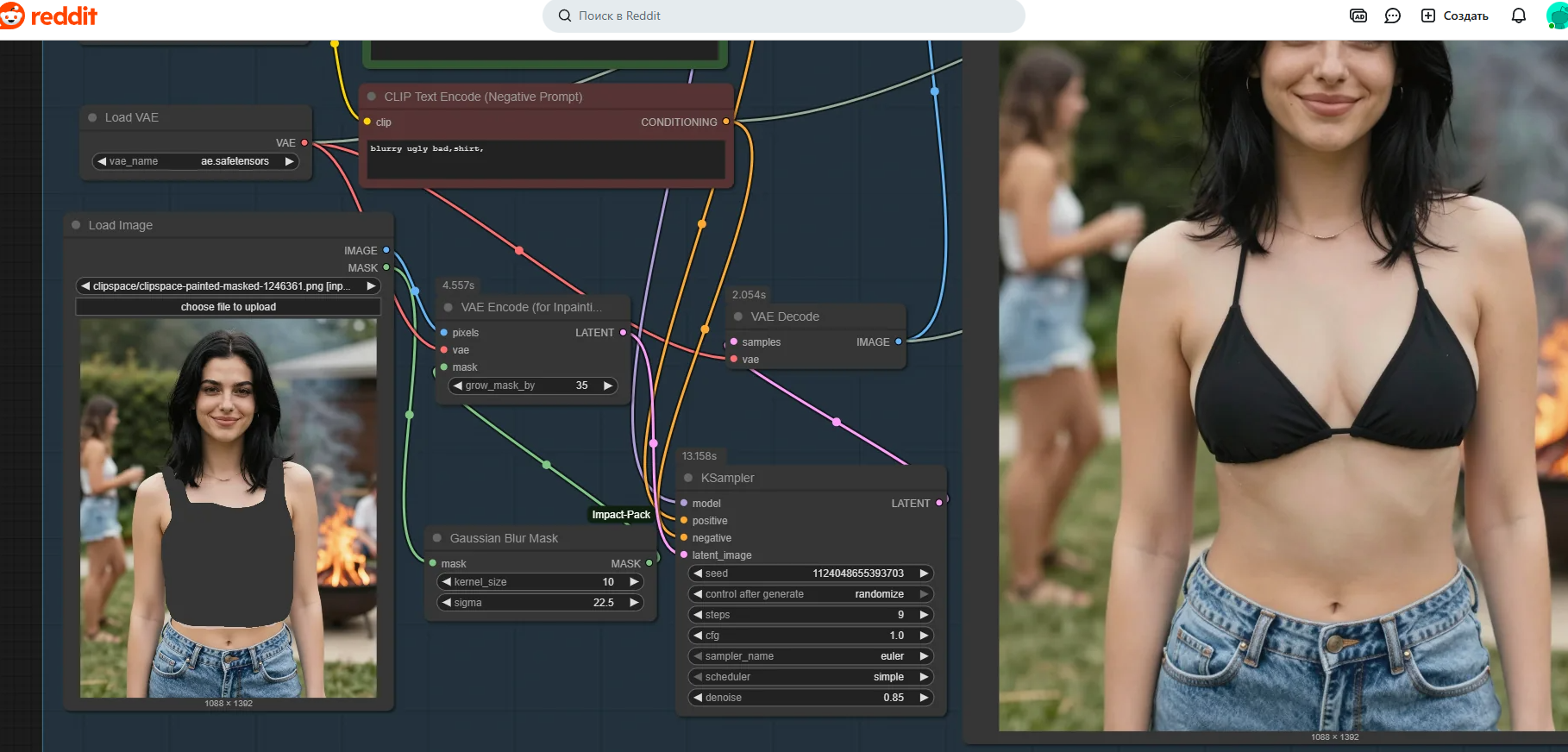

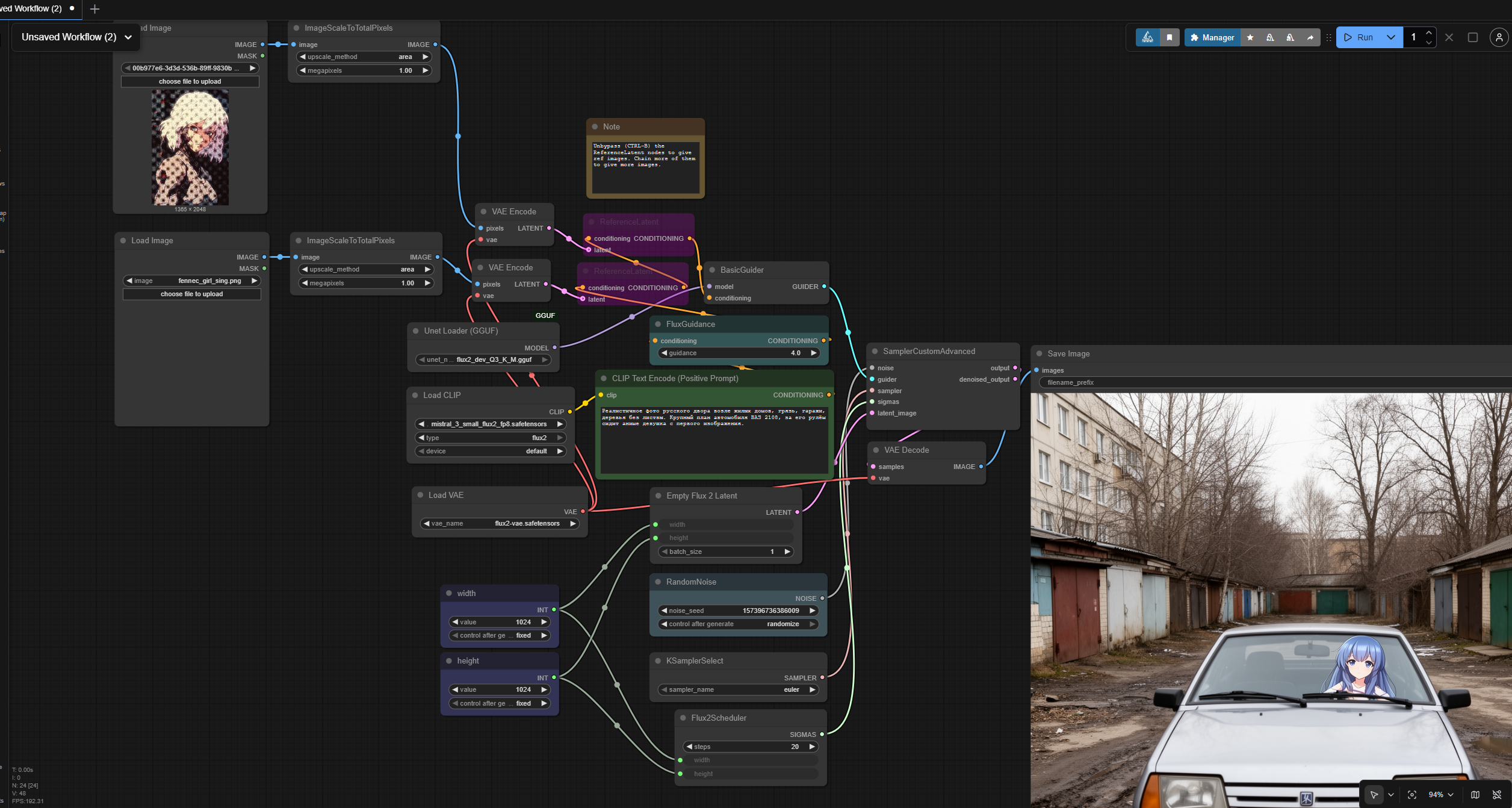

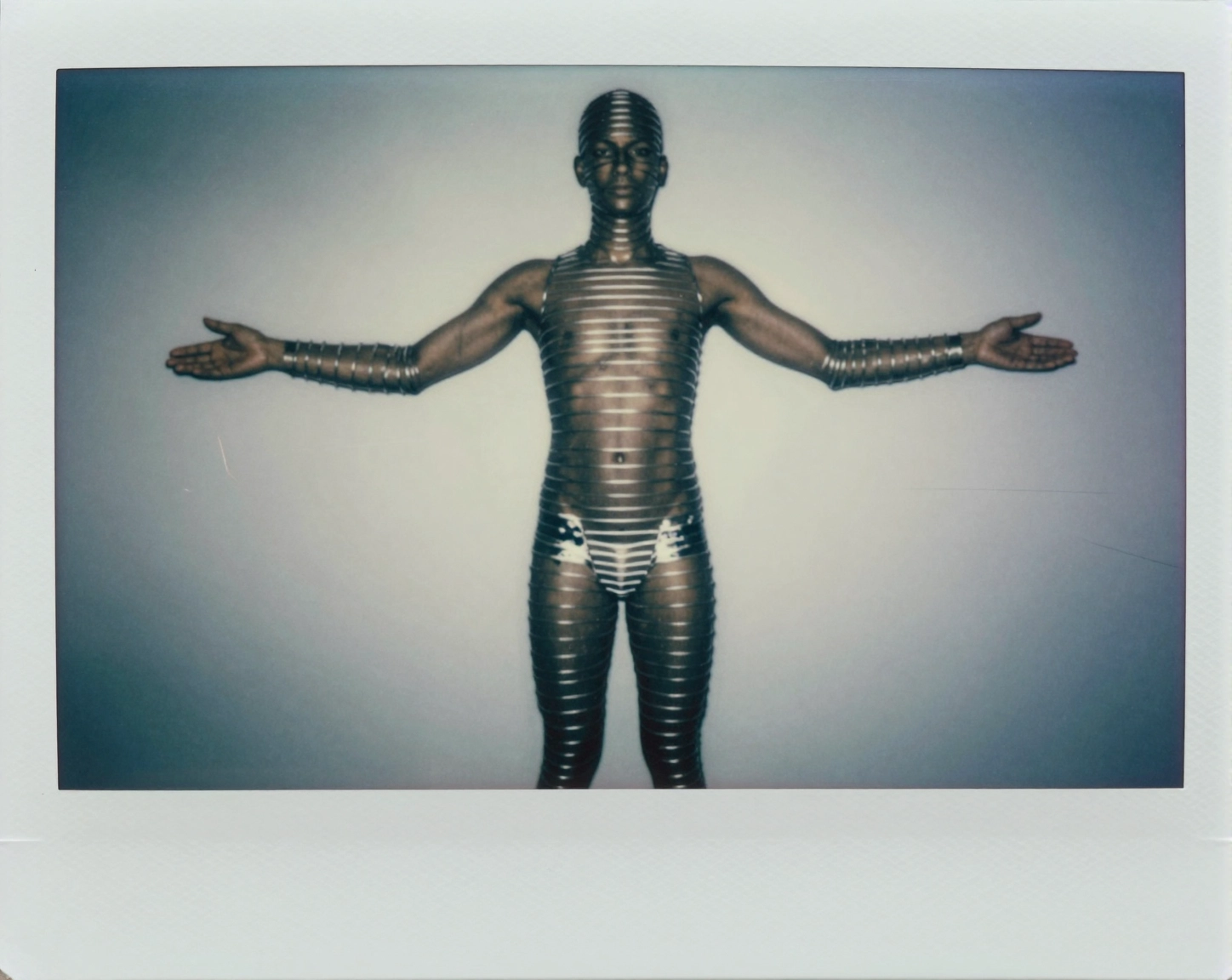

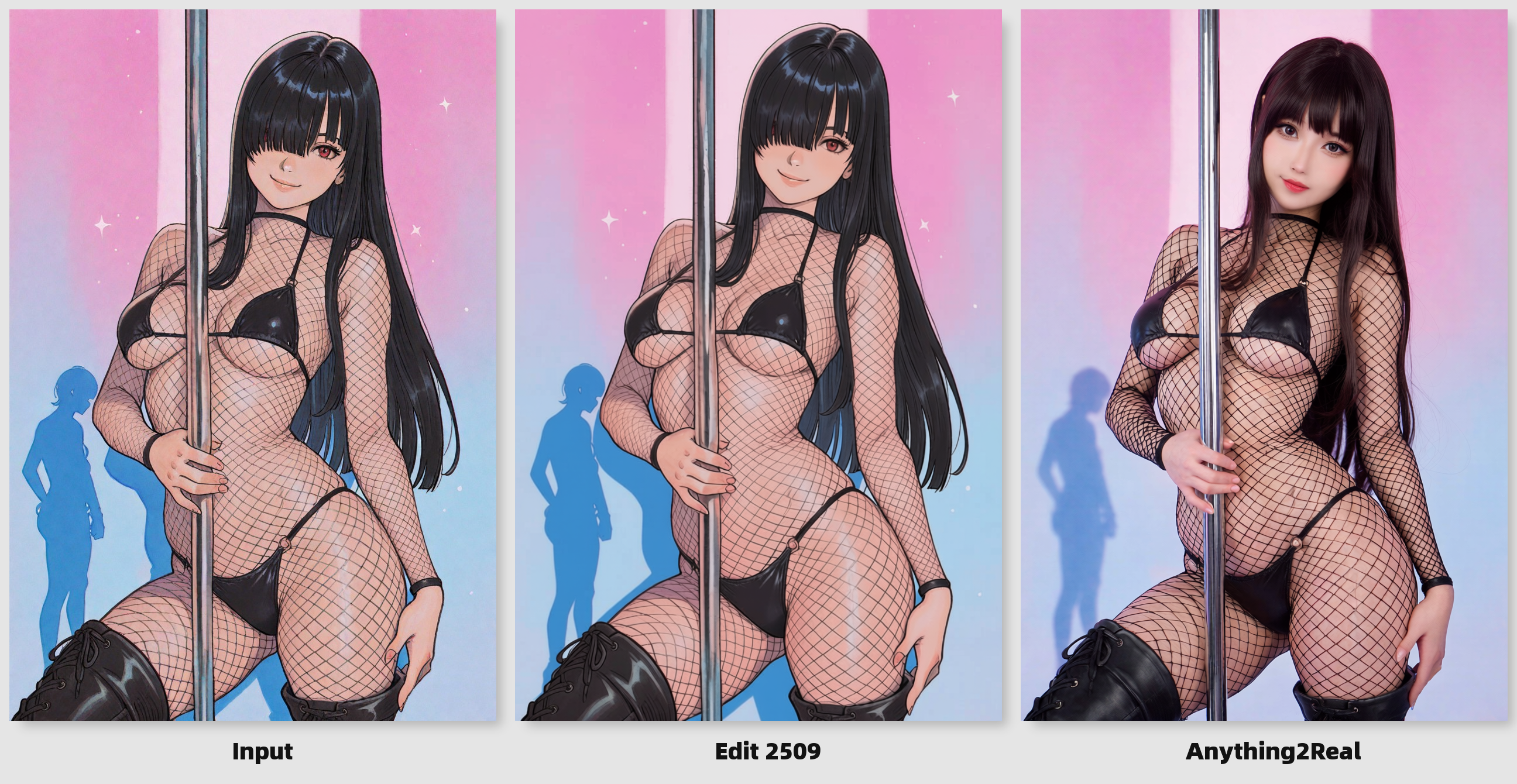

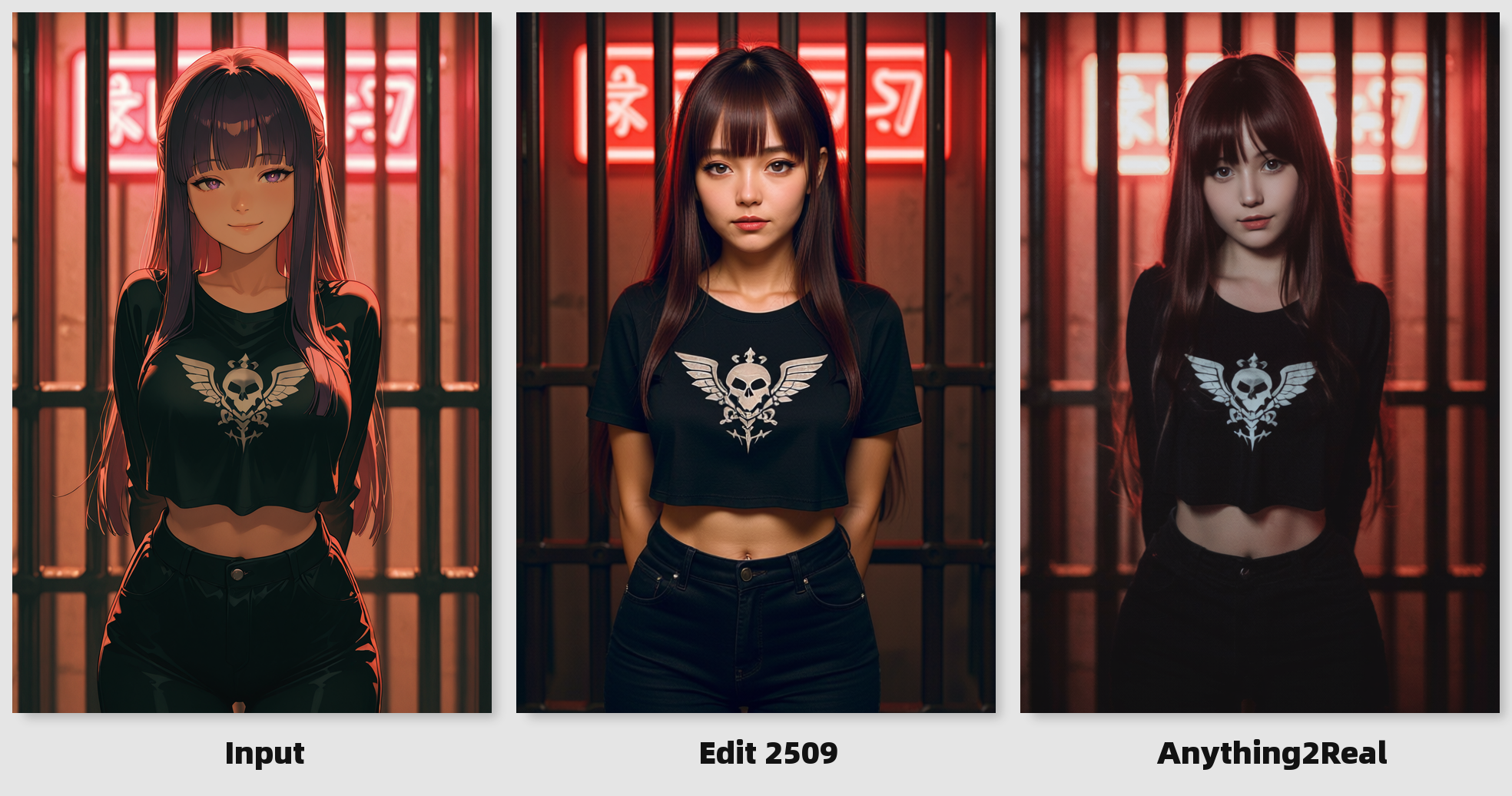

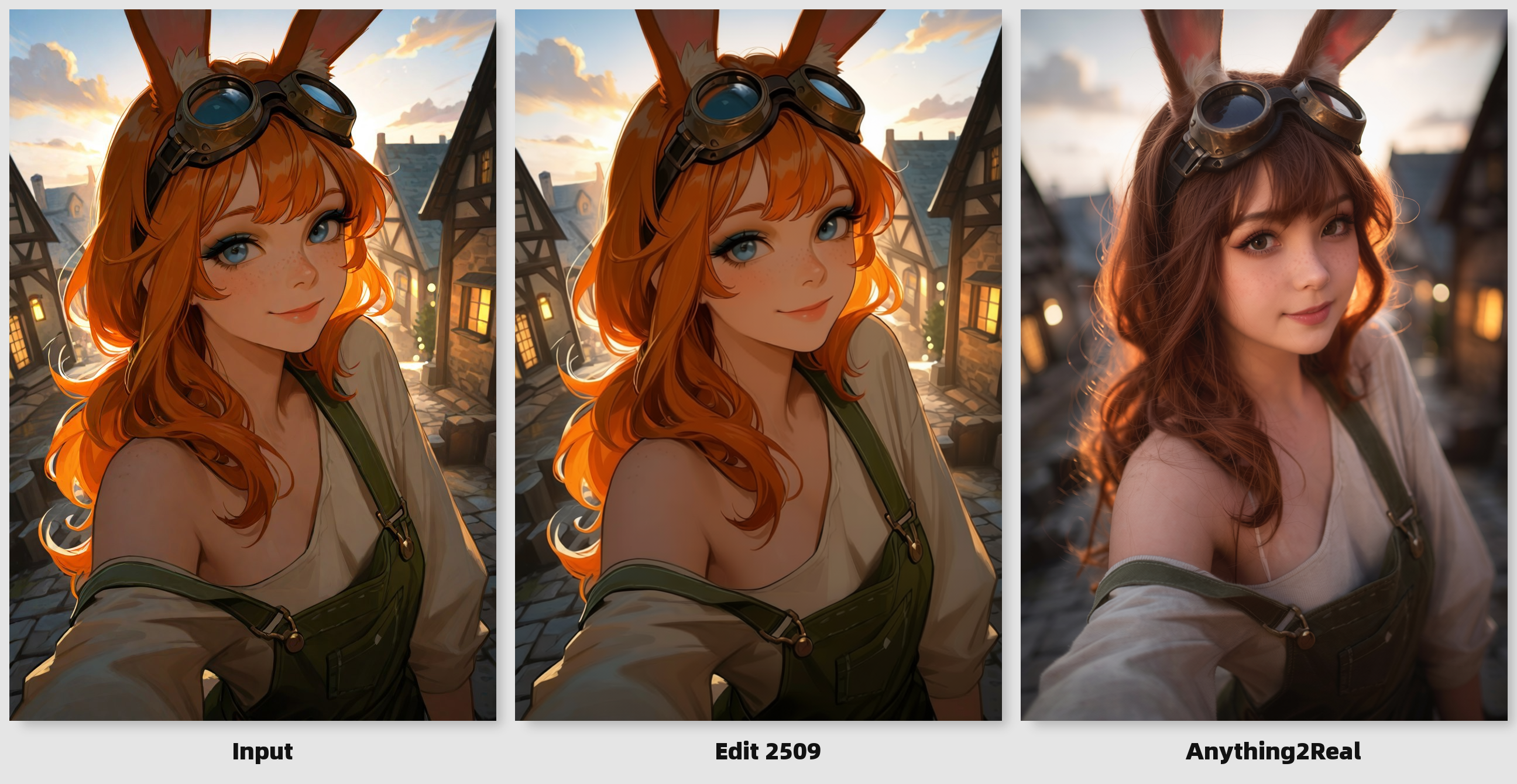

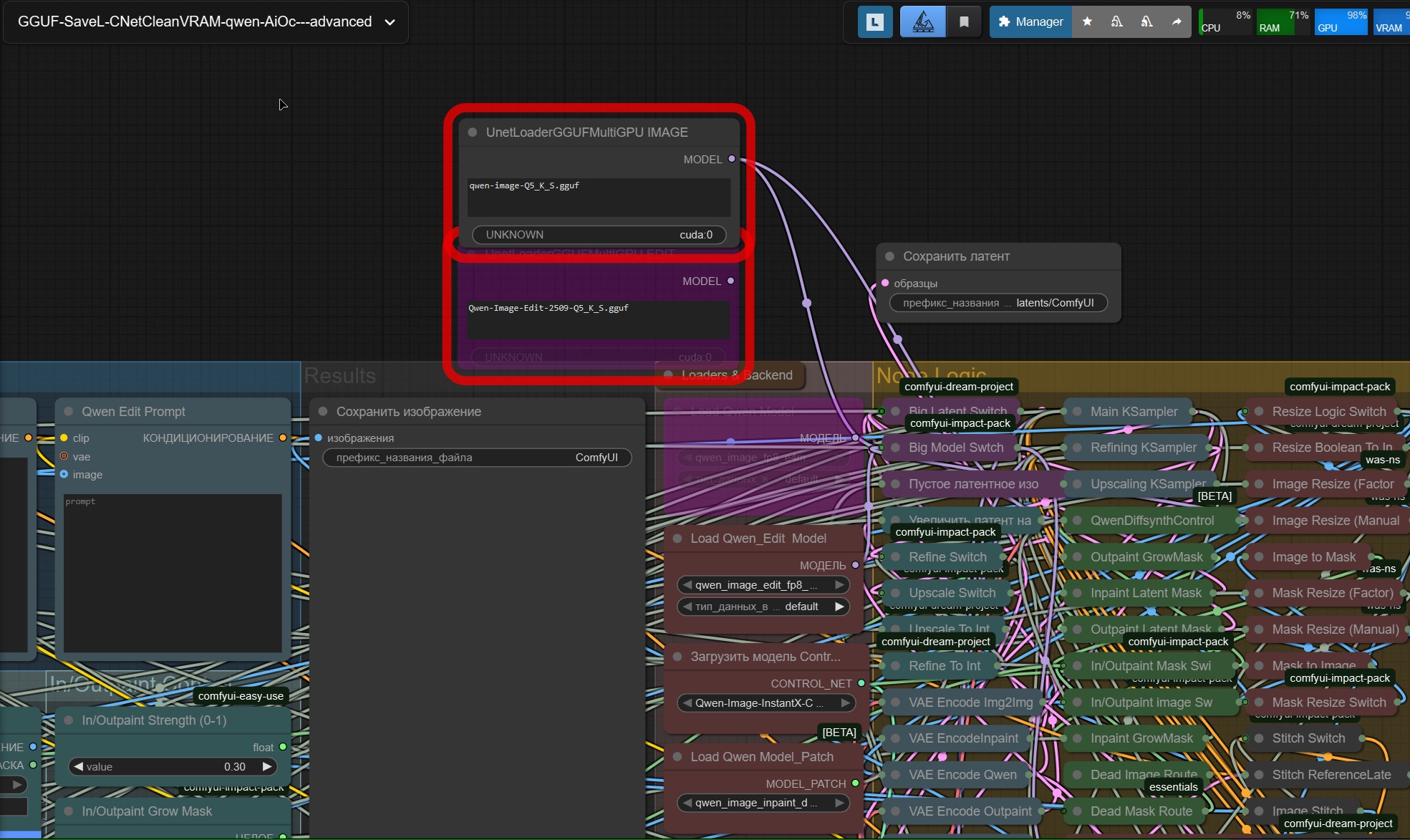

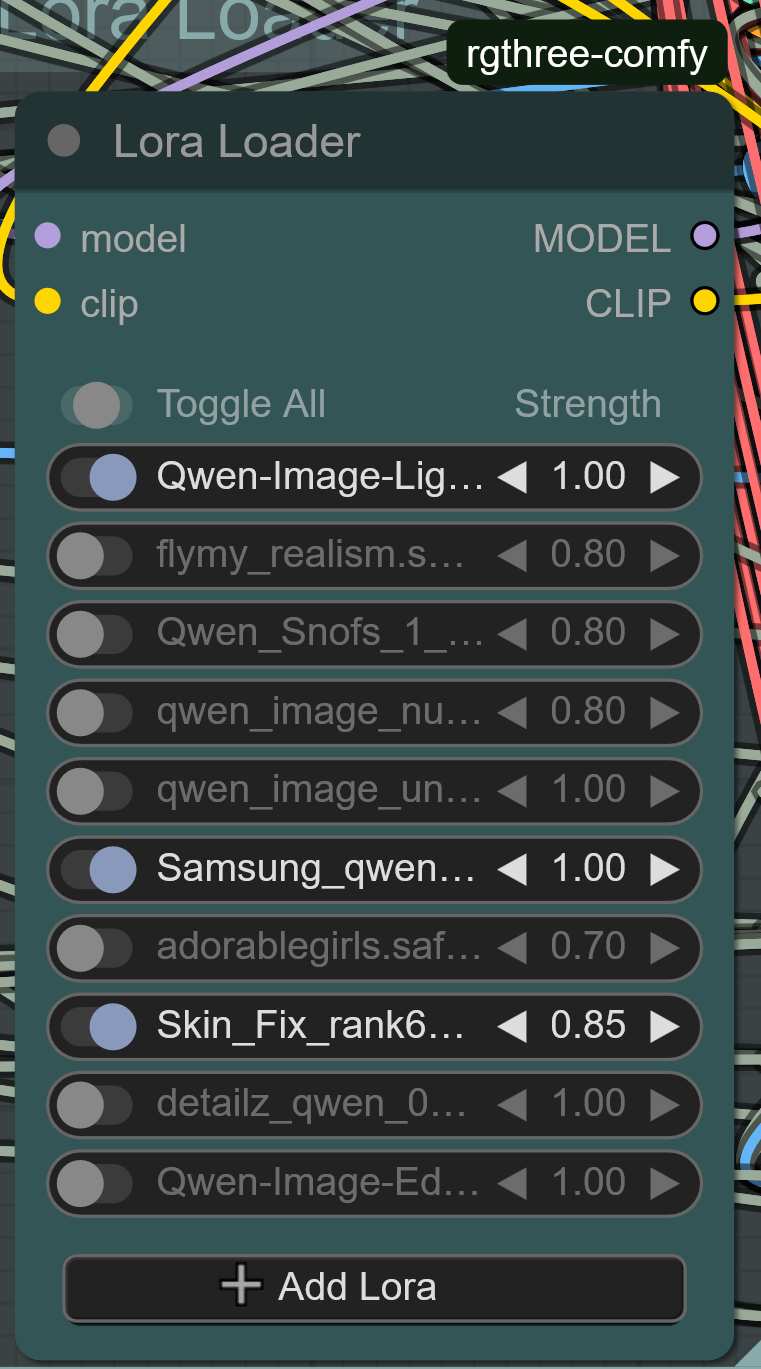

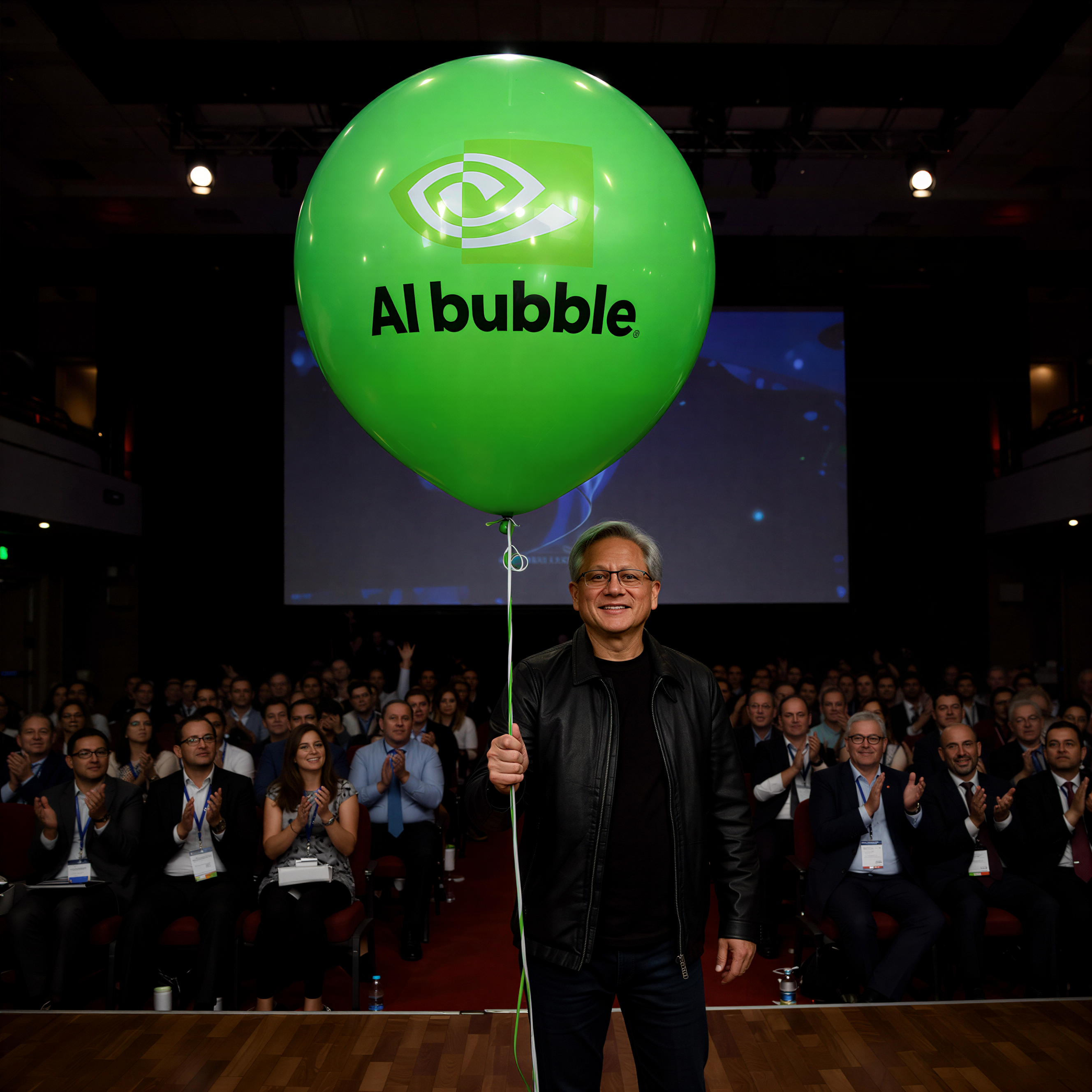

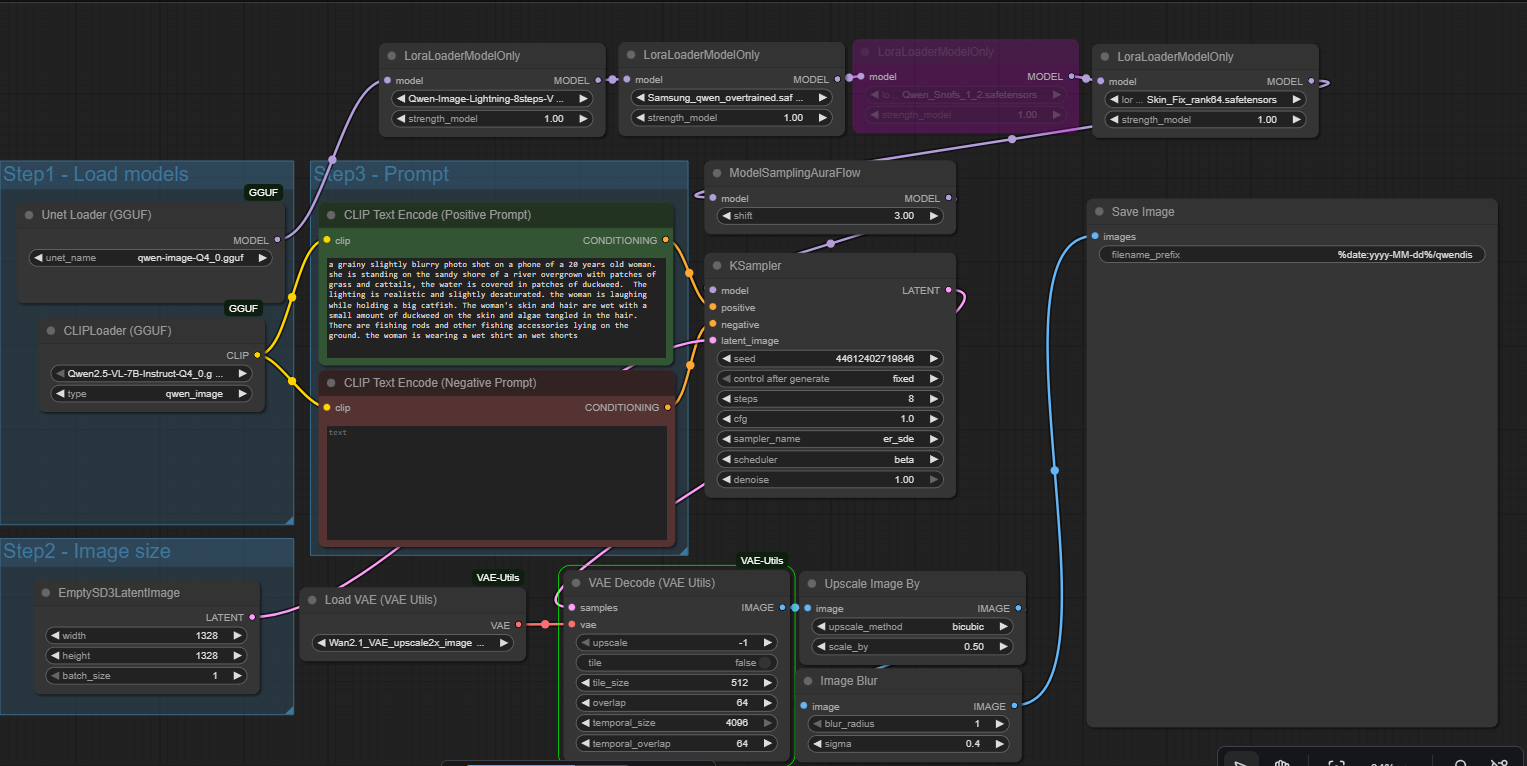

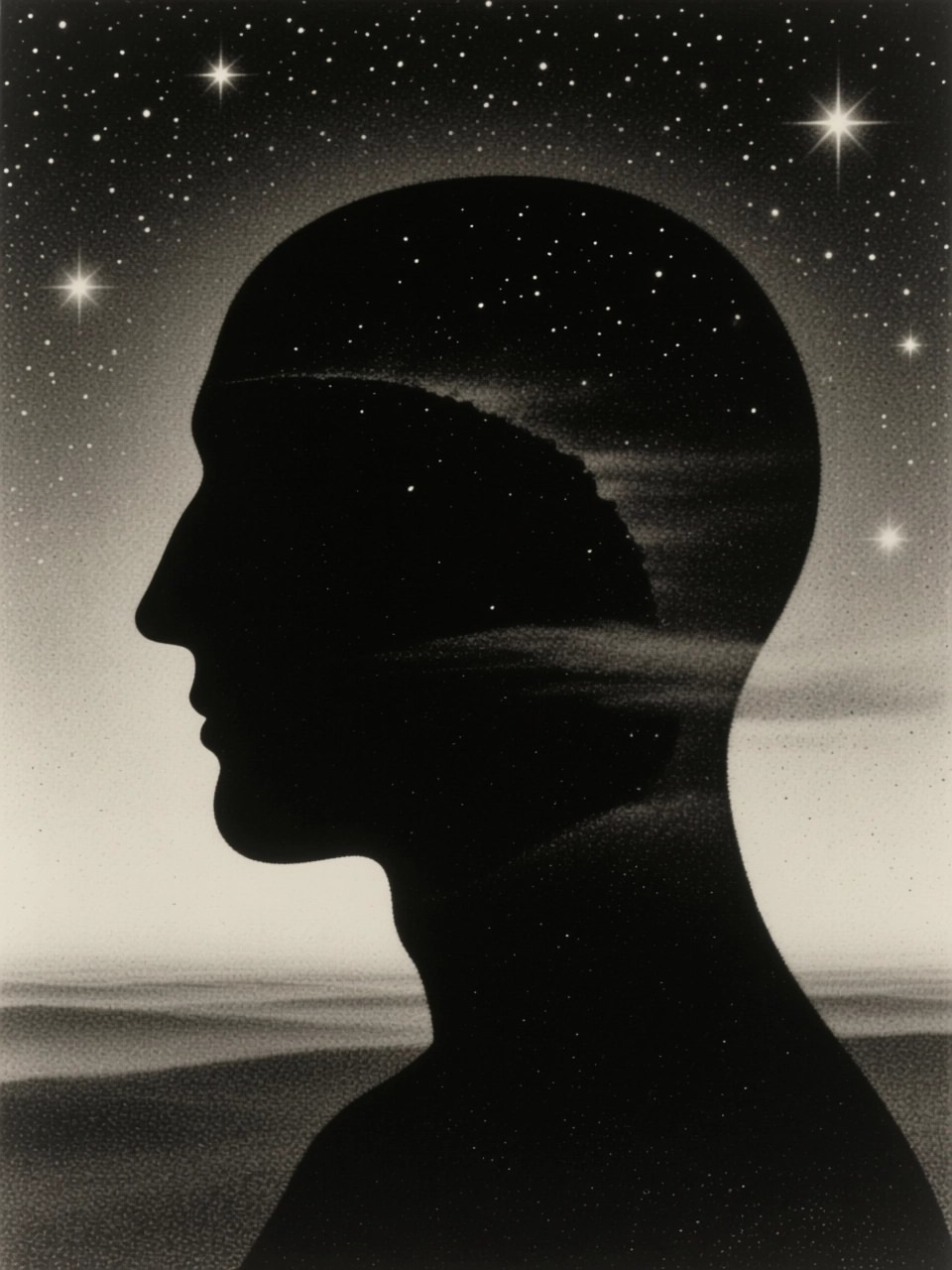

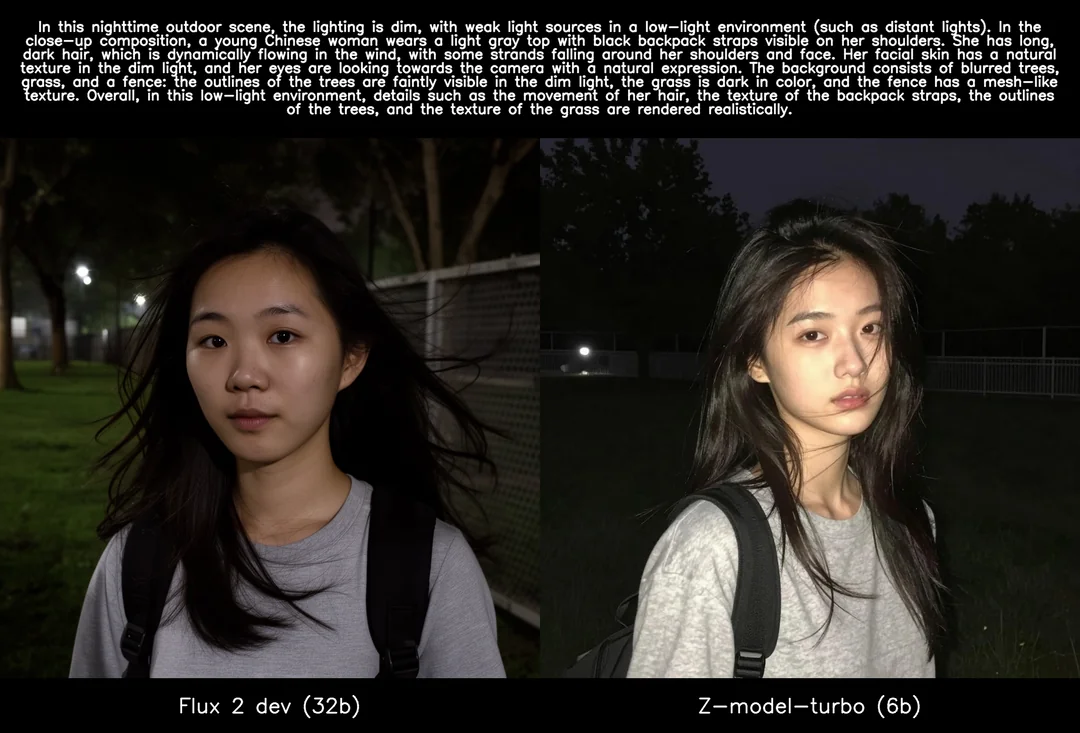

Очередная новая модель от китайцев уделывает Flux 2 в плане реалистичности

Аноним

# OP

27/11/25 Чтв 11:04:16

№

327