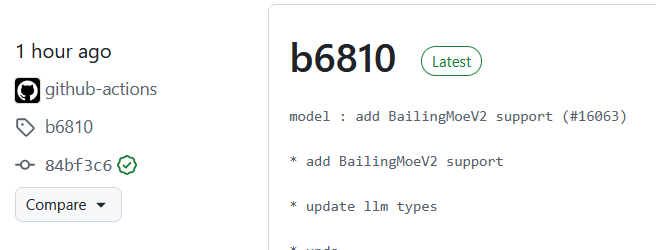

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №172 /llama/

Аноним

14/10/25 Втр 21:23:00

№

1