Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №170 /llama/

Аноним

06/10/25 Пнд 17:39:38

№

1

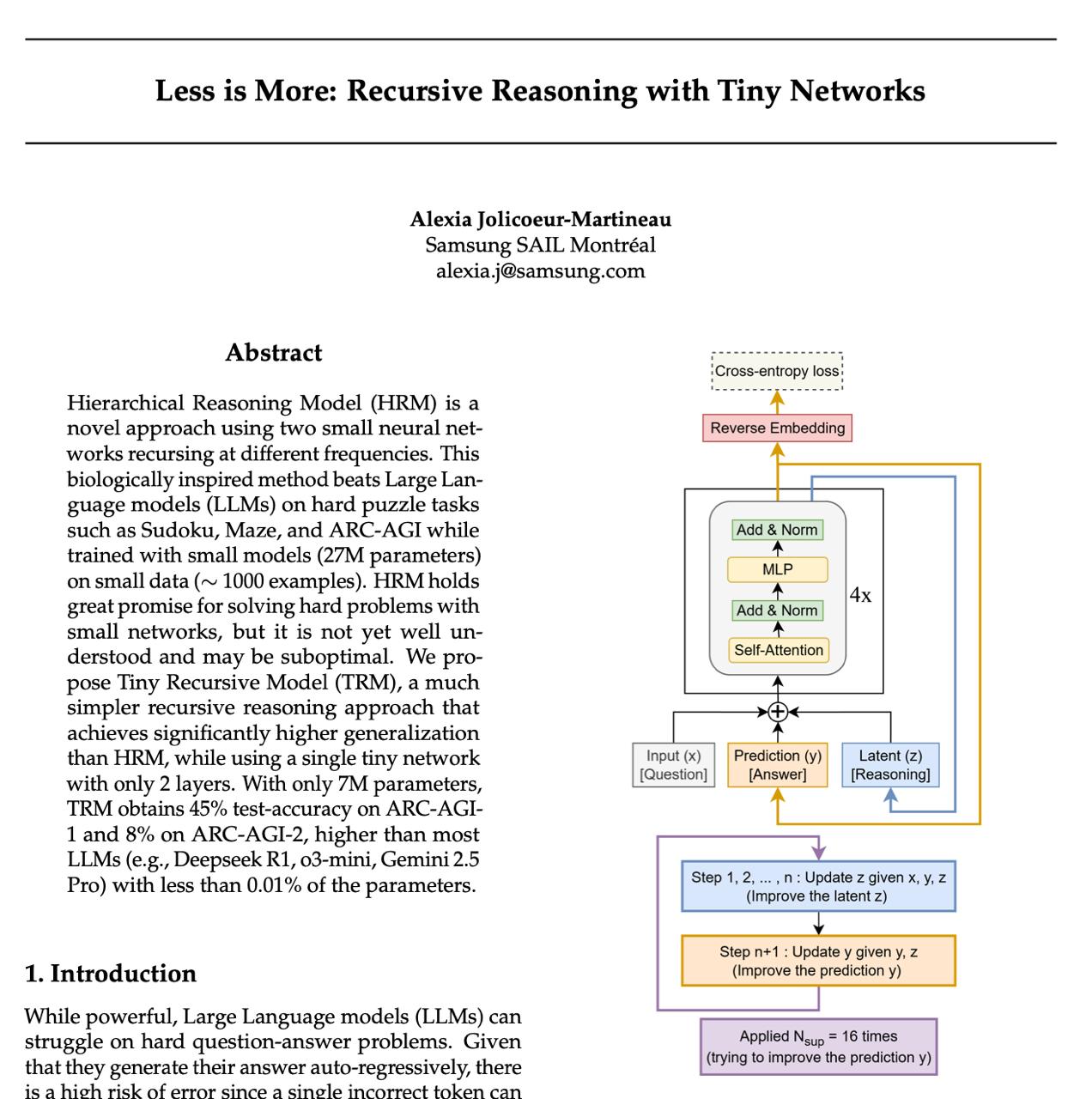

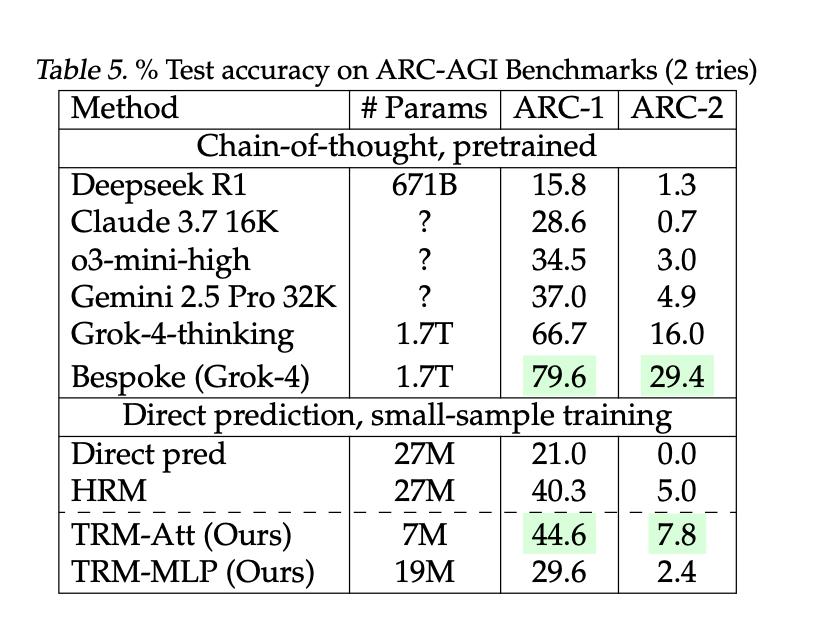

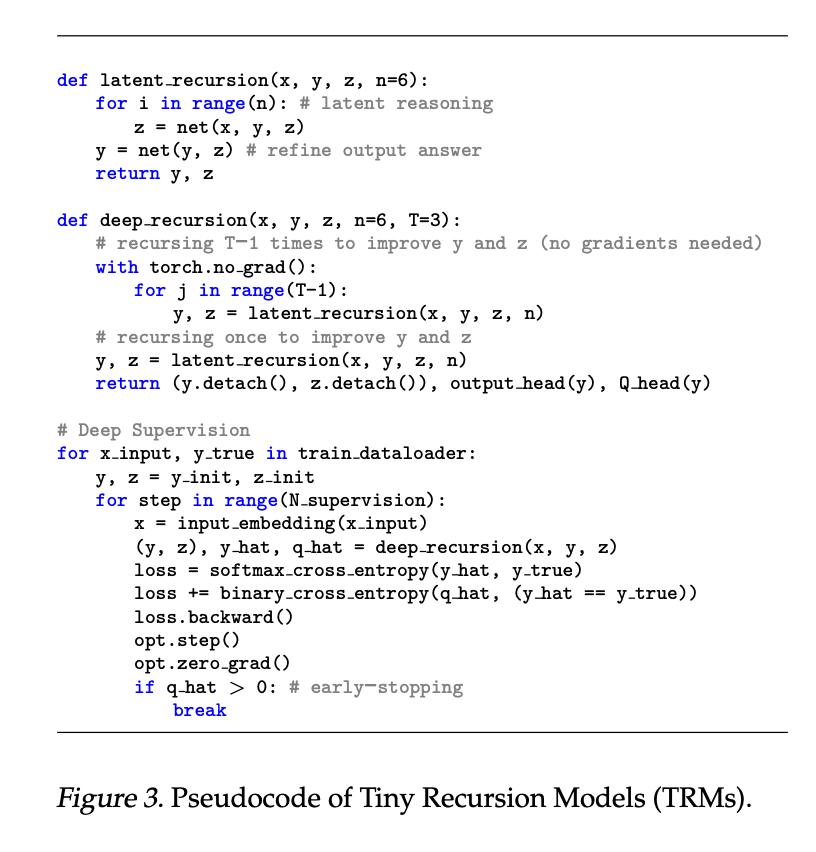

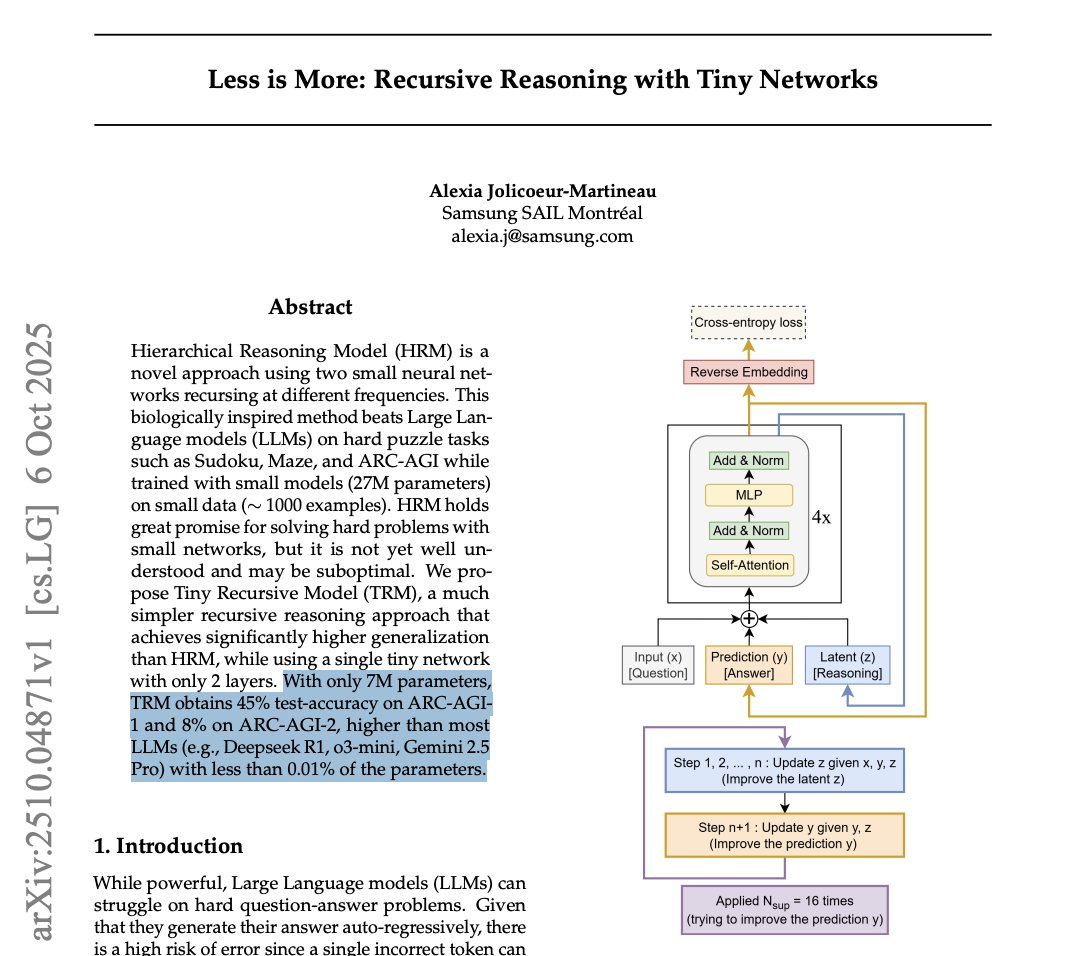

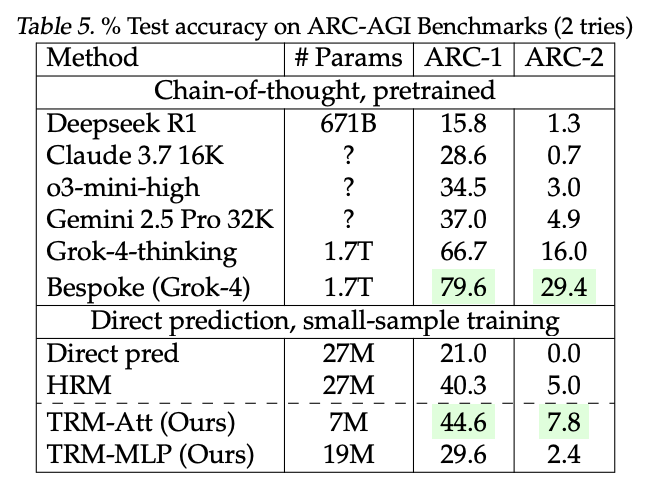

Крошечная модель на 7 миллионов параметров превзошла DeepSeek-R1, Gemini 2.5 Pro и o3-mini на ARG-AG

Аноним

10/10/25 Птн 08:28:25

№

281