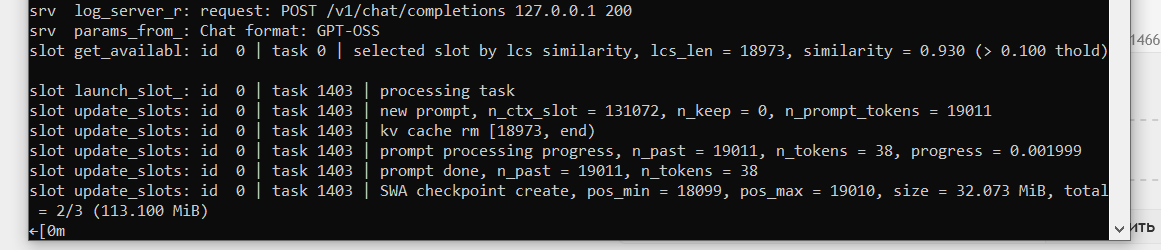

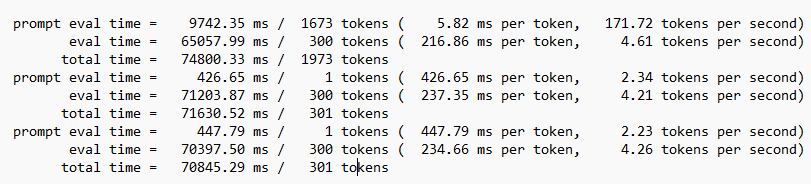

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №171 /llama/

Аноним

12/10/25 Вск 01:49:57

№

1