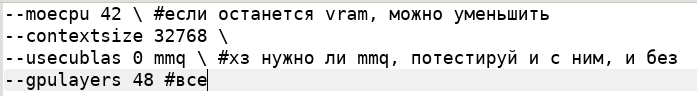

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №166 /llama/

Аноним

19/09/25 Птн 08:06:19

№

1