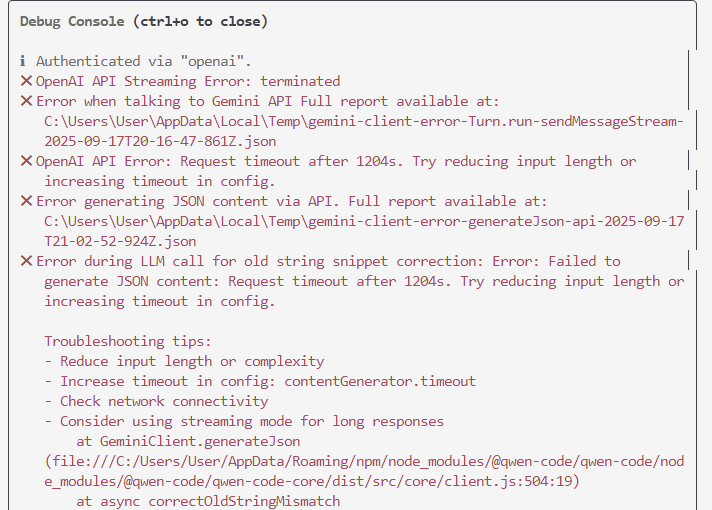

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №165 /llama/

Аноним

14/09/25 Вск 18:11:11

№

1