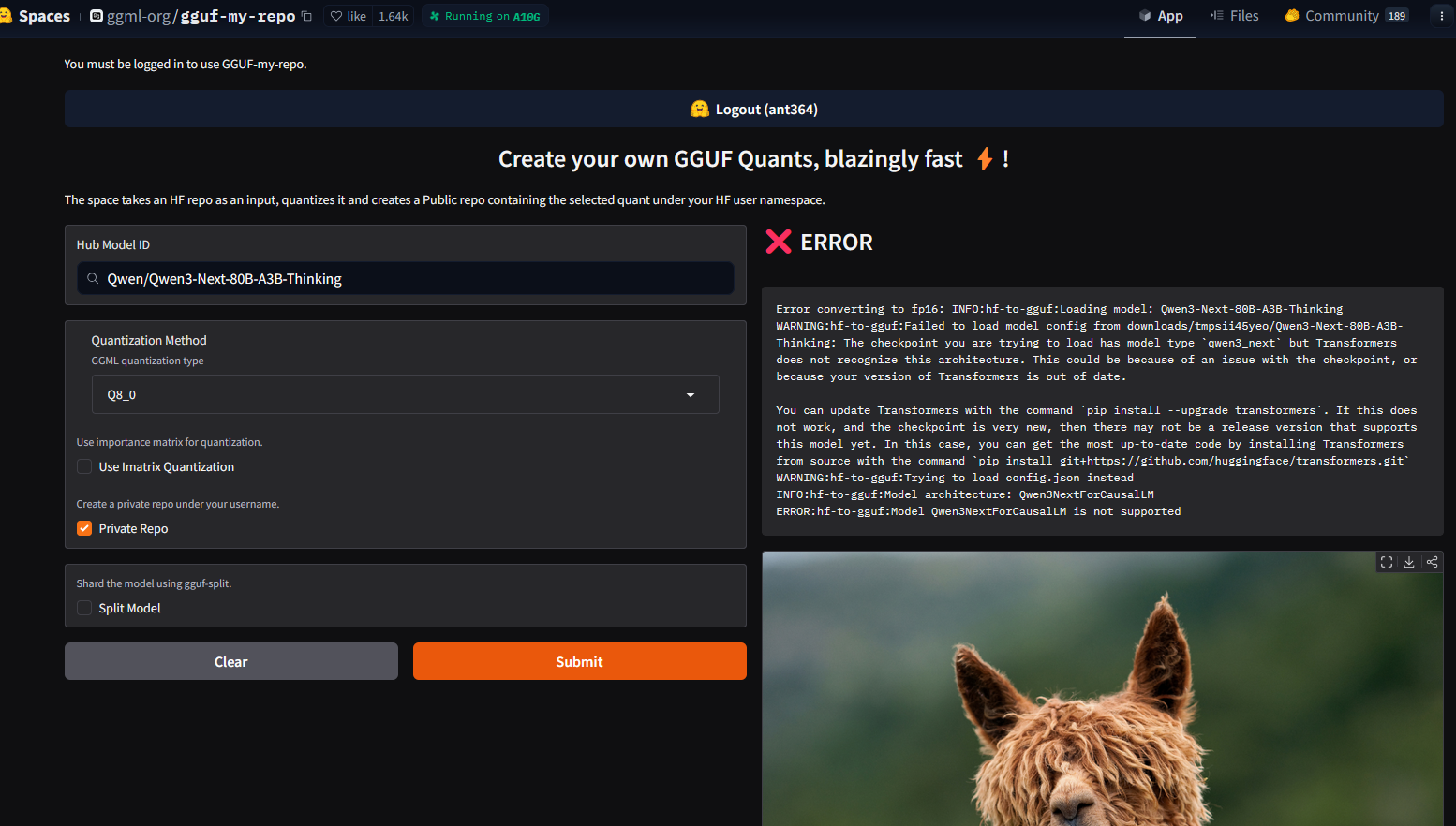

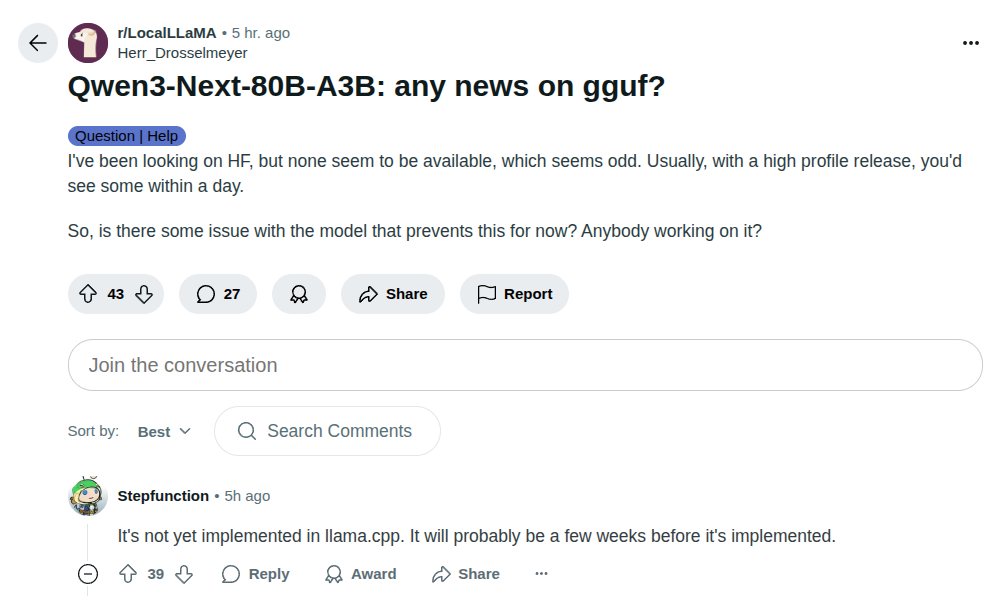

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №164 /llama/

Аноним

09/09/25 Втр 02:33:12

№

1