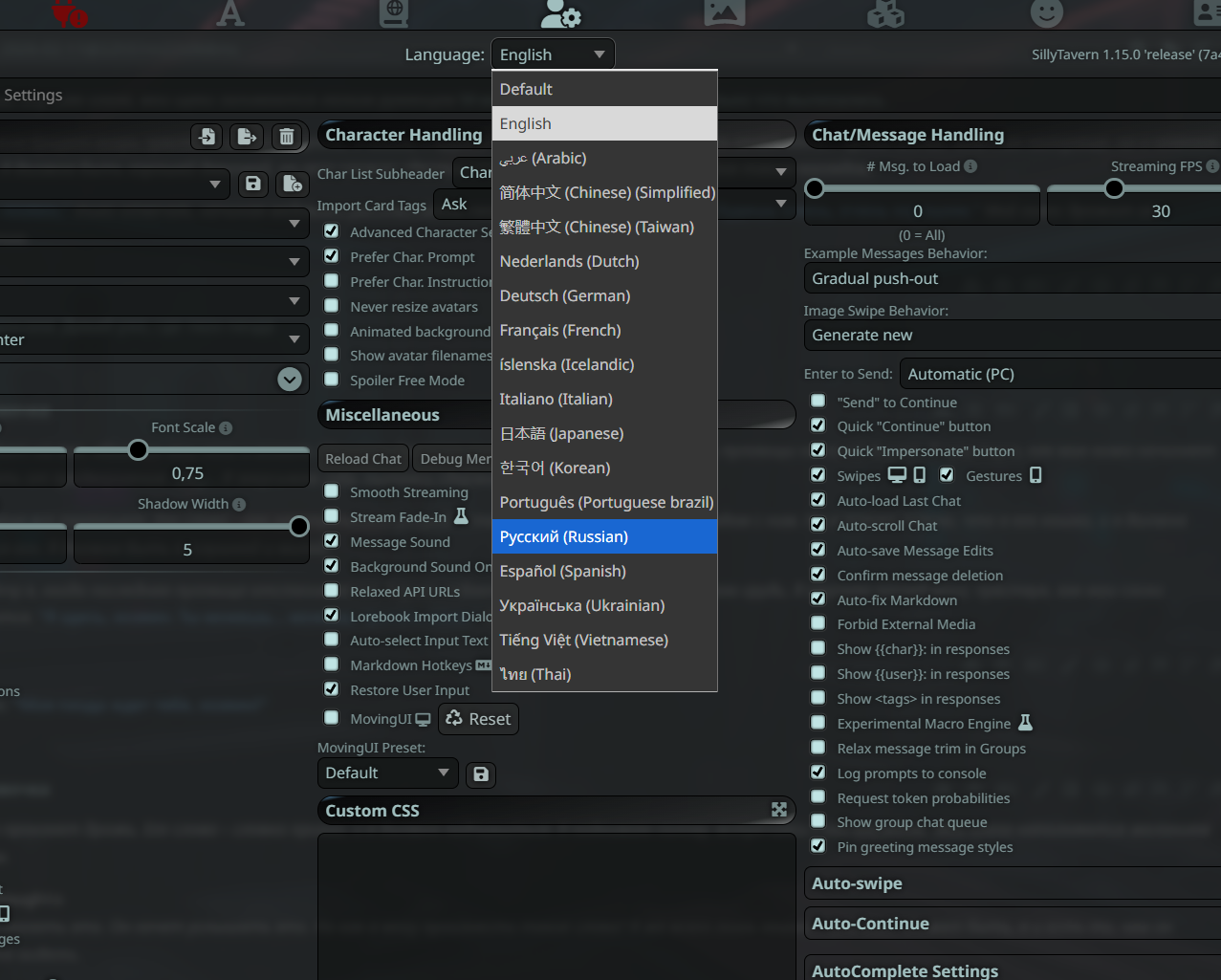

Локальные языковые модели (LLM): LLaMA, Gemma, Qwen и прочие №197 /llama/

Аноним

15/02/26 Вск 20:39:52

№

1