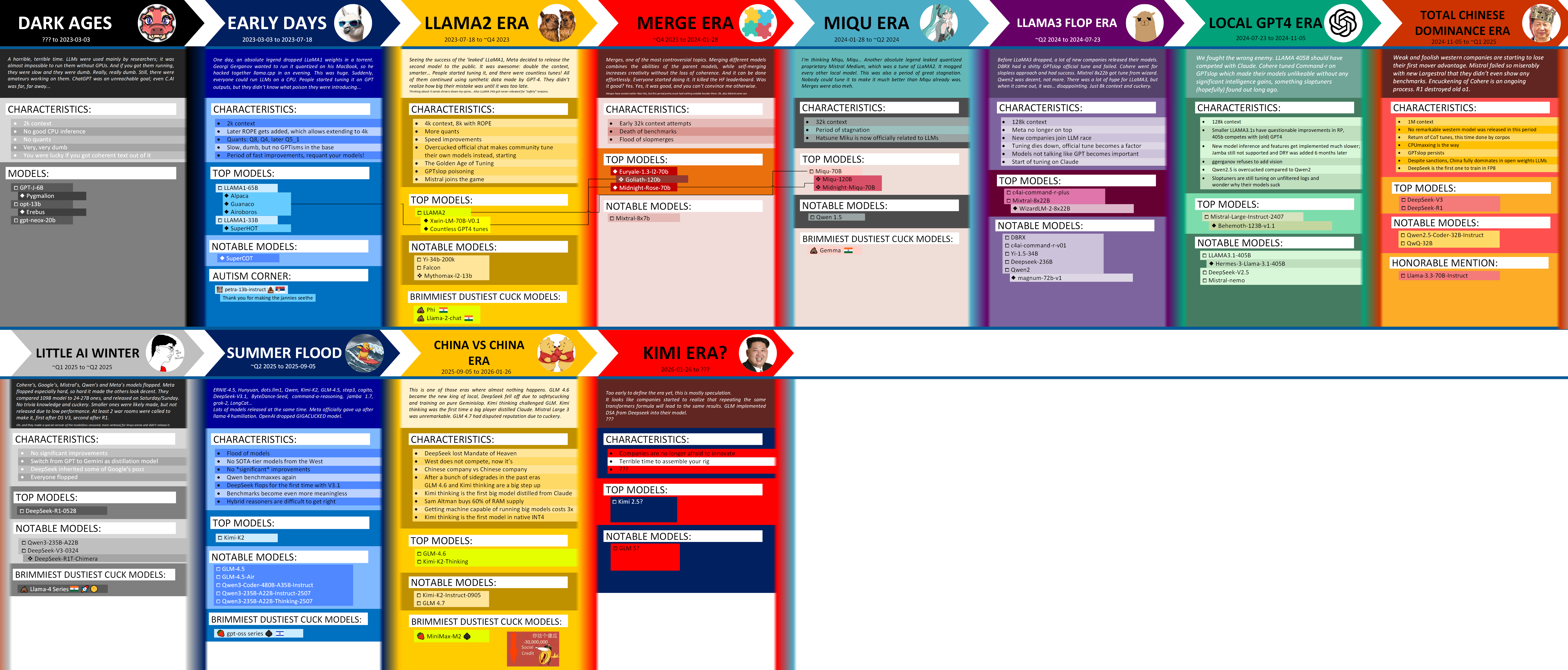

Локальные языковые модели (LLM): LLaMA, Gemma, Qwen и прочие №196 /llama/

Аноним

12/02/26 Чтв 09:48:28

№

1