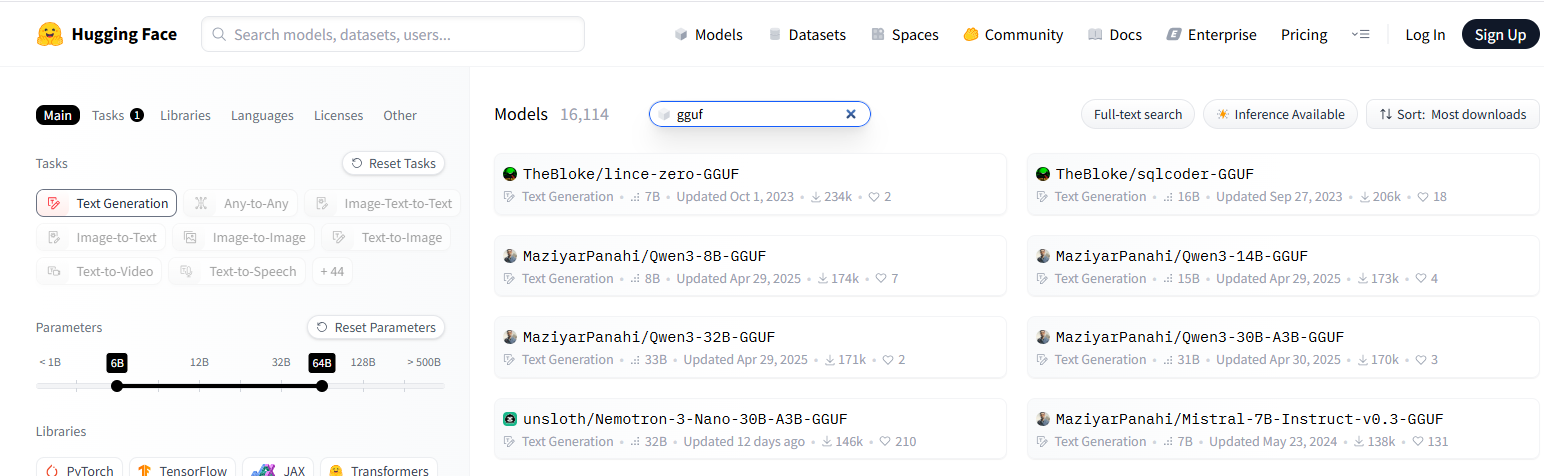

Локальные языковые модели (LLM): LLaMA, Gemma, Qwen и прочие №188 /llama/

Аноним

10/01/26 Суб 18:53:06

№

1