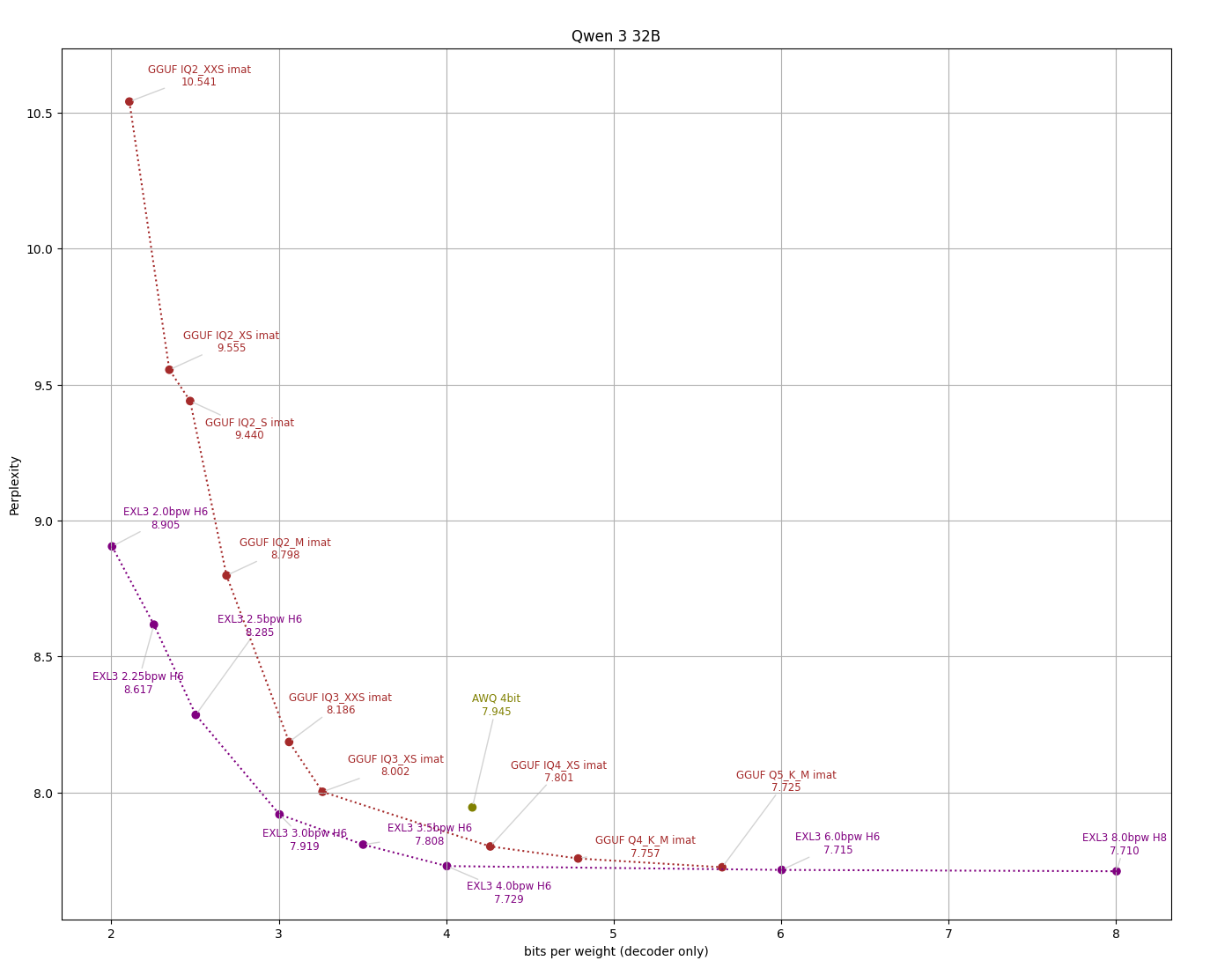

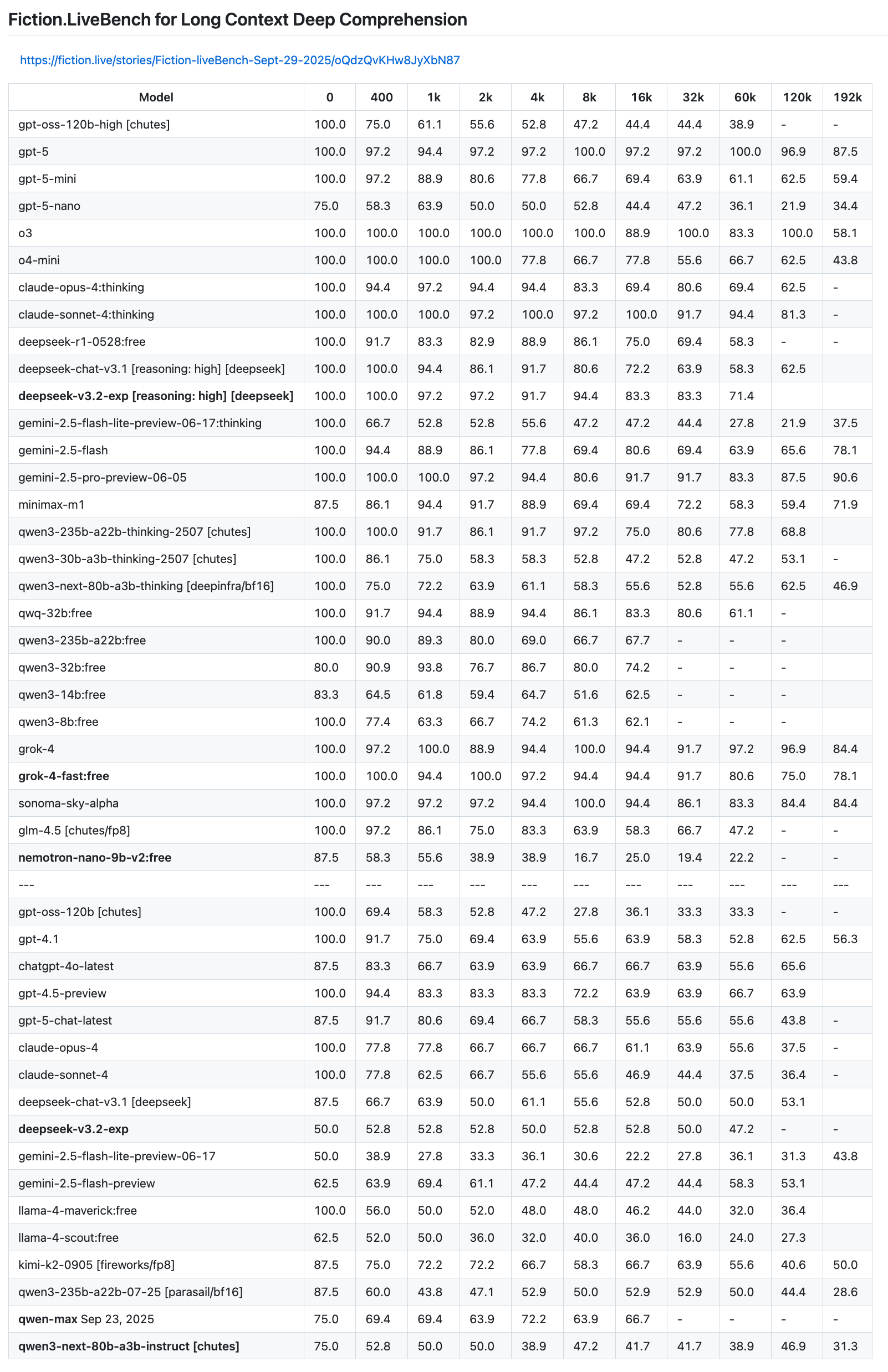

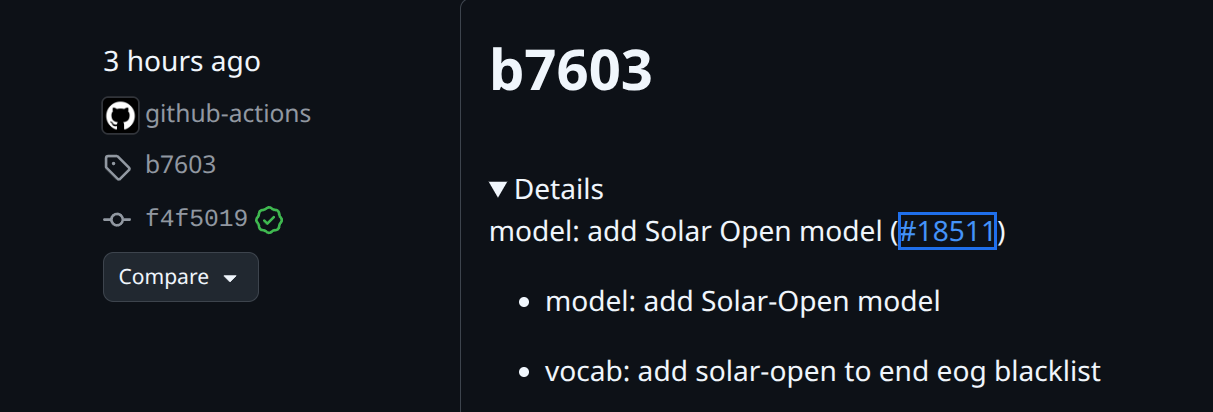

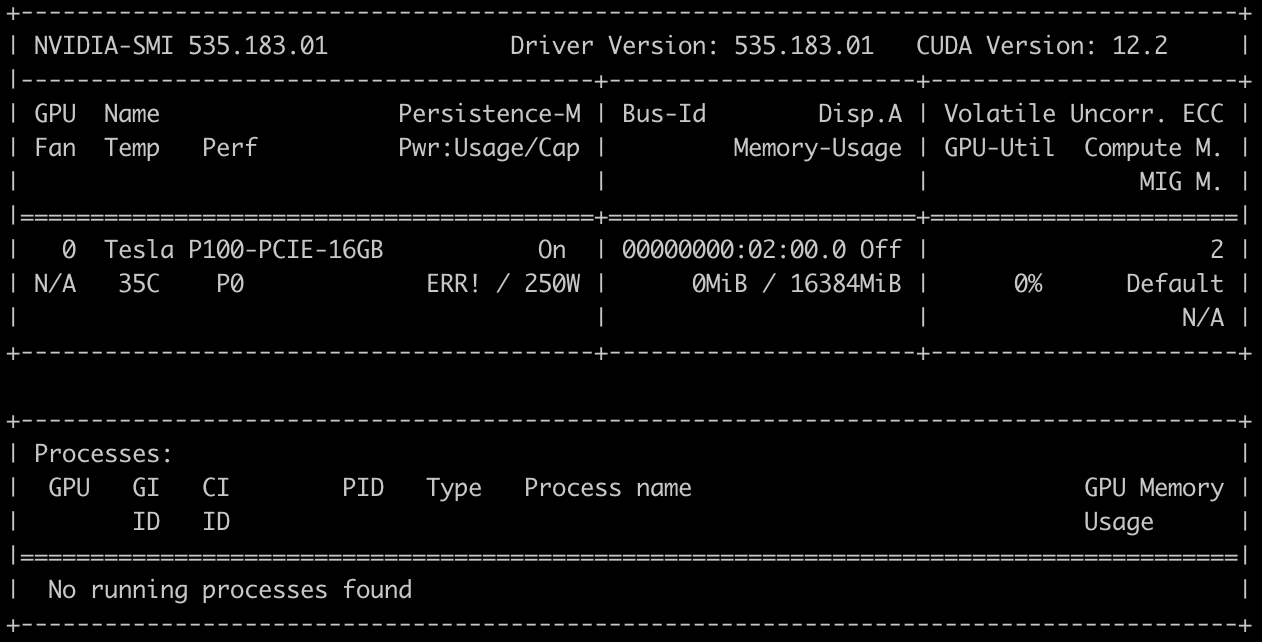

Локальные языковые модели (LLM): LLaMA, Gemma, Qwen и прочие №186 NY Edition /llama/

Аноним

31/12/25 Срд 23:21:20

№

1