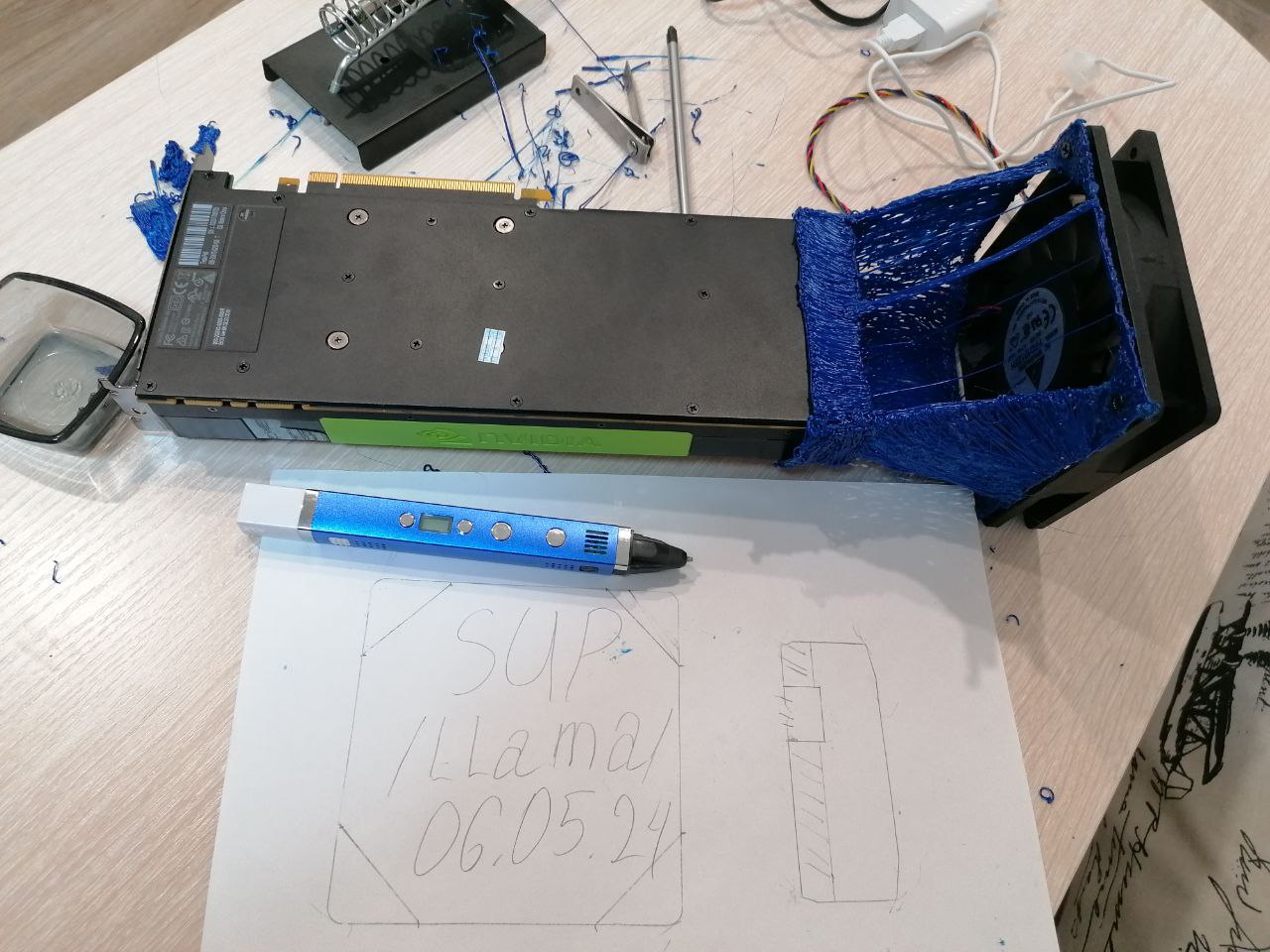

Локальные языковые модели (LLM): LLaMA, Gemma, Qwen и прочие №176 /llama/

Аноним

06/11/25 Чтв 02:39:07

№

1