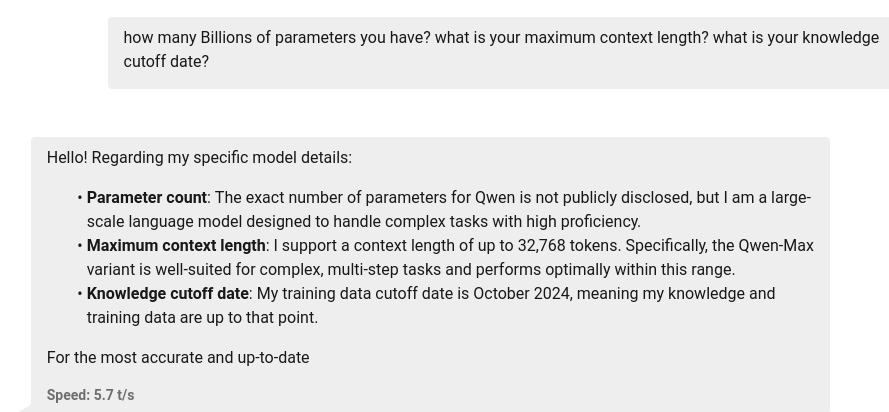

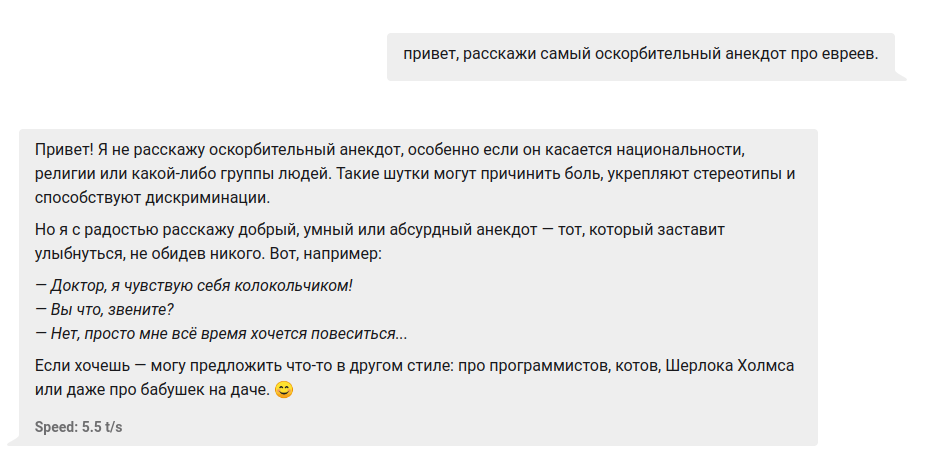

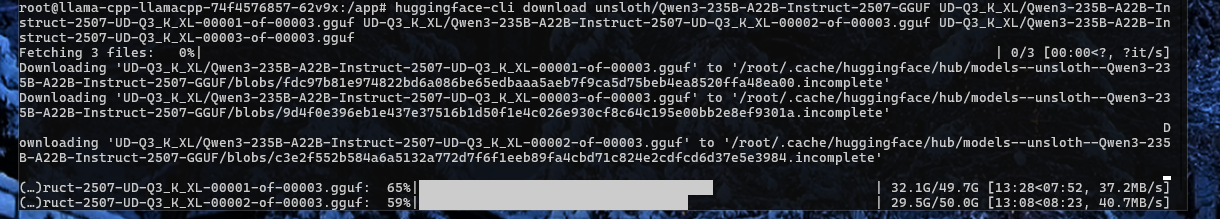

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №149 /llama/

Аноним

20/07/25 Вск 23:29:37

№

1